Rust Algorithm Club

歡迎來到 Rust 演算法俱樂部!本專案受 Swift Algorithm Club 啟發,專案中的演算法皆使用 Rust 程式語言撰寫說明與實作!您可以在 Rust Algorithm Club 一站,依您的意願,挑選有興趣的演算法知識學習;若您夠大膽,推薦您閱讀自動生成的 API 文件,直接單挑程式原始碼。

本專案原始碼放在 GitHub 上,非常期待您的貢獻。

基礎概念

演算法

搜尋

排序

簡單排序:

高效排序:

混合排序(更高效):

特殊排序:

資料結構

堆疊與佇列

鏈結串列

關聯容器

字串處理

學習資源

有許多優秀的網站與學習資源,分享給大家學習演算法。

- VisuAlgo - 也許是最好的演算法視覺化專案。

- Big-O Cheat Sheet - 最全面的 Big O cheat sheet。

- Rosetta Code - 使用各種程式語言,解答上百種不同程式問題。

- Competitive Programmer’s Handbook - 讓你更有競爭力。這書本身也很有競爭力。

如何貢獻

歡迎各式各樣的貢獻,修正錯字也行!開始動手之前,請先閱讀貢獻指南。

貢獻者

授權條款

本專案分為兩部分授權:

- 程式碼與函式庫依據 The MIT License (MIT) 授權條款發佈。

- 文章與相關著作依據 Creative Commons 4.0 (CC BY-NC-SA 4.0) 授權條款發佈。

Copyright © 2017 - 2021 Weihang Lo

漸進符號 Asymptotic Notation

日常生活中,你會如何描述處理事情的效率?

「原來她五分鐘內可以吃掉一頭牛!」

「房間這麼小你還能擺一堆雜物?還不快收拾!」

這些描述方法,著重在處理事情的花費時間,或單位空間內的儲存量。描述演算法的效率也如此,就是「測量演算法的執行成本」,例如這個排序法花了 10 秒鐘跑完兩萬筆資料,或是這個模擬演算法很吃資源需要 32 GB 的記憶體。

然而,在不同的機器規格、環境溫濕度、程式語言、實作方式,以及有沒有放乖乖的變異影響下,相同演算法的執行成本常常不一致。為了消弭這些外部因素,讓分析演算法能夠更科學化。科學家抽絲剝繭,發明一個方法:

「統計演算法內所需操作步驟的數目。」

這是最簡單,最粗淺比較不同演算法效率的作法。

用數學表示演算法效率

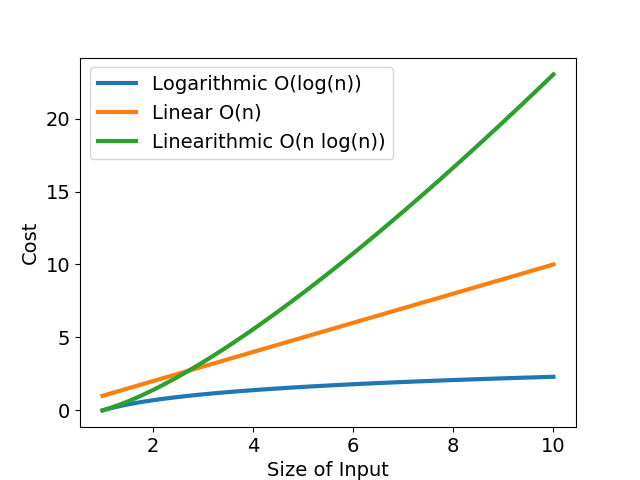

「計算步驟數目」很像中小學的數學題目:某公司有三個能力相異的工程師,有的工程師一天解決一個 bug,有的工程師連續工作後效率大幅滑落。每個工程師的除蟲效率可以畫成「bug 數 - 解決 bug 所需時數」函數,橫軸為待處理的臭蟲數,縱軸為解決臭蟲所需時數,如圖一與表所示。

| 時數 | $\log N$ | $N$ | $N \log N$ |

|---|---|---|---|

| $N=5$ | 2.236 | 5 | 8.046 |

| $N=30$ | 5.477 | 30 | 102.036 |

不論從圖或表,我們都可以明確看出,當 bug 數目小時,每個工程師耗時差不多;當 bug 數目成長到一定程度時,效率好與效率差的工程師差距就很明顯了。

我們把場景拉回演算法的範疇,再闡明一次。上述的除蟲效率函數關係,可以簡單視為為「輸入資料量 - 運算成本」關係之函數。例如 $f(x)=x^2+3x+6$。當輸入資料量增大時,成本也隨之上升,這個用來描述演算法執行成本與輸入資料量之關係的函數,我們稱之為該演算法的「複雜度」。

何謂漸進符號

了解每個演算法的時間複雜度之後,就能比較何者效率佳。但往往天不從人願,給了我們兩個演算法進行比較。

$$f(x)=\sqrt{\frac{182777}{286}}\pi x^4+5\log_{3}^{26}88x^3-e^{777^{log_2^9}}$$

$$g(x)=3x^6-2x^2$$

「天啊!這樣要怎麼分析執行效率呀!」

為了有統一的加薪標準,我們不能假定產品只會產生特定數量的臭蟲,也不能以單一天的工作表現判定員工能力,我們知道老舊系統有無限多個 bug,因此,優秀的老闆關心的是工程師長期處理「海量臭蟲」,在極限下的成長趨勢,這些成長趨勢才是衡量 KPI 的關鍵。再次強調,優秀老闆關心如何榨出是工程師的「極限成長趨勢」,而非一時半刻賣弄學識。

同樣地,有太多因素干擾影響一個演算法的複雜度,假使我們只觀察當輸入資料量 $n$ 接近無窮大時,演算法的成長趨勢為何,就很接近所謂漸進符號(asymptotic notation)的定義。漸進符號 只關心演算法在極限下的漸進行為,不同的演算法可能使用相同的漸進符號表示。

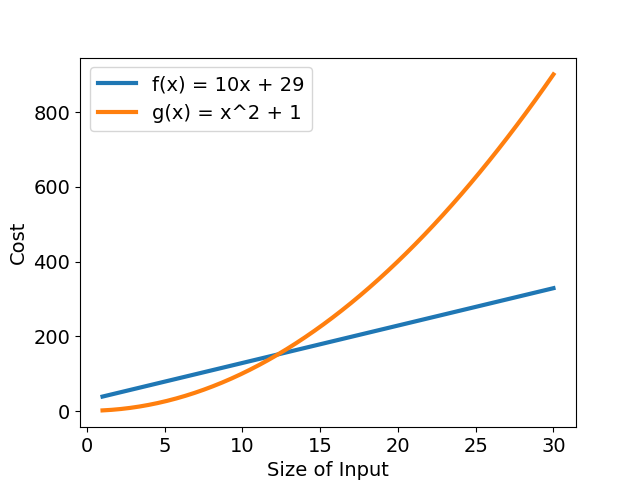

我們比較兩個簡單函數,$f(x) = 10x + 29$ 以及 $g(x) = x^2 + 1$。從圖二可以看出一開始 $g(x)$ 的執行時間比 $f(x)$ 多了不少,但隨著輸入資料量 $n$ 增多,$g(x)$ 的執行時間成長愈來愈快速,最後遠遠大於 $f(x)$。

若以 $an^2 + bn + c$ 表示複雜度,就是當存在一個 $a > 0$ 時,一定會有 $n$ 符合 $an^2 > bn + c$,這個差距隨著 $n$ 越大越明顯,這是因為首項(leading term),也就是帶有最高指數的那一項,隨著 輸入大小改變,執行時間變化幅度較大。因此,可捨去複雜度函數中其他較不重要的次項與常數,留下最大次項,「透過簡單的函數來表述函數接近極限的行為」,讓複雜度函數更易理解,這就是「漸進符號」的概念。

這裡介紹常見的幾種漸進符號:

$O$:Big O

當我們談論演算法複雜度時,通常關心的是演算法「最糟糕的情況下」,「最多」需要執行多久。Big O 就是描述演算法複雜度上界的漸進符號,當一個演算法「實際」的複雜度(或執行成本對輸入資料量函數)為 $f(n)$ 時,欲以 Big O 描述其複雜度上界時,必須滿足以下定義:

$$f(n) = O(g(n)) \colon {\exists k>0\ \exists n_0\ \forall n>n_0\ |f(n)| \leq k \cdot g(n)}$$

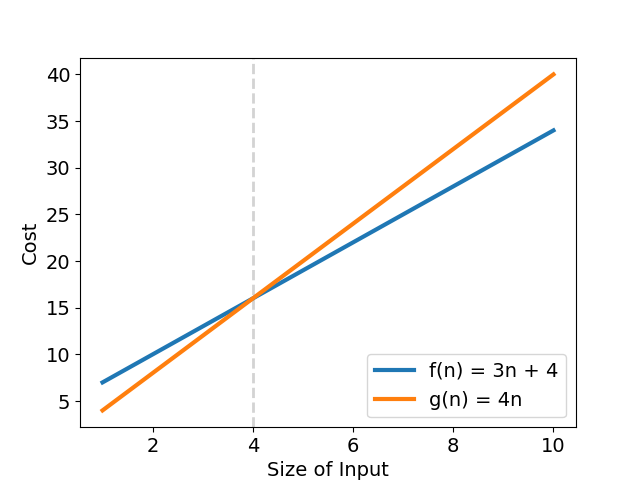

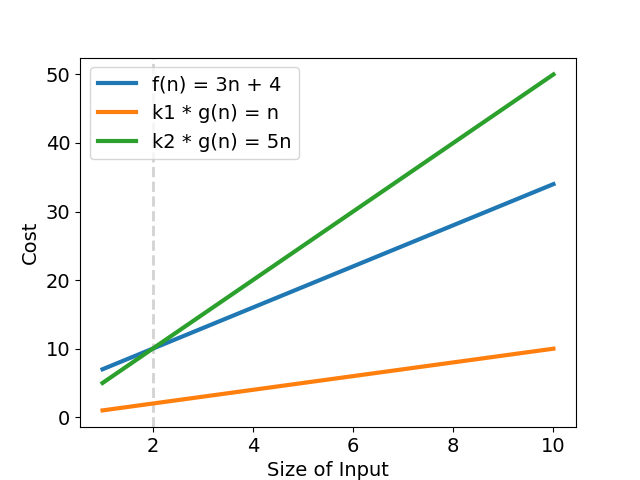

假設有一演算法實際複雜度為 $f(n) = 3n + 4$,有一組 $k = 4;\ g(n) = n;\ n_0 = 4$ 滿足

$$\forall n > 4,\ 0 \leq f(n) = 3n + 4 \leq 4n$$

意思是「$f(n)$ 的複雜度上界成長趨勢最終不會超過 $g(n) = 4n$ 」,再代入 $O(g(n))$,可得演算法最差複雜度為 $f(n) = O(n)$,也就是「該演算法的成長趨勢不會比 $g(n)$ 來得快」(見圖三)。

再多看一個例子,若 $f(n) = 4n^2 + n$ 有一組 $k = 5;\ g(n) = n^2;\ n_0 = 5$ 滿足

$$\forall n > 5,\ 0 \leq f(n) = 4n^2 + n \leq 5n^2$$

則此函數的複雜度為 $f(n) = O(n^2)$。

注意:也寫作 $f(n) \in O(g(n))$,因為實際上 $O(g(n))$ 是所有可描述演算法成長趨勢,並滿足上述條件的函數之「集合」。

$\Omega$:Big Omega

相較於 Big O 描述演算法成長趨勢的上界,Big Omega 則是對應成長趨勢的「下界」,定義如下:

$$f(n) = \Omega(g(n)) \colon {\exists k>0\ \exists n_0\ \forall n>n_0\ |f(n)| \geq k \cdot g(n)}$$

以 $f(n) = 3n + 4$ 為例,有一組 $k = 2;\ g(n) = n;\ n_0 = 0$ 滿足上式,因此這個演算法在輸入資料夠大時,「至少」會達到 $\Omega(n)$ 的複雜度,也就是「該演算法的成長趨勢不會比 $g(n)$ 來得慢」。

$\Theta$:Big Theta

Big Theta 則是 Big O 與 Big Omega 兩個漸進上下界所夾出的範圍,表示該演算法在輸入資料夠大時,最終的複雜度會成長到這個範圍中。其定義如下:

$$f(n) = \Theta(g(n)) \colon {\exists k_1>0\ \exists k_2>0\ \exists n_0\ \forall n>n_0\ k_1 \cdot g(n) \leq |f(n)| \leq k_2 \cdot g(n)}$$

繼續以 $f(n) = 3n + 4$ 為例,同樣有一組 $k_1 = 1;\ k_2 = 5;\ g(n) = n;\ n_0 = 2$,滿足

$$\forall n \geq 2,\ n \leq f(n) = 3n + 4 \leq 5n$$

可得知,$f(n) = 3n + 4 \in \Theta(n)$,表示「該演算法的成長趨勢與 $g(n) = n$ 相同」(見圖四)。

常見的複雜度

看完了讓人昏昏欲睡的數學定義,現在來認識一些常見的複雜度,從最快最有效率,到最慢最拖台錢的通通一起認識。

- $O(1)$:常數時間,演算法執行時間與資料量毫無瓜葛。例如讀取 array 首個元素。

- $O(\log n)$:執行時間隨資料量呈對數比例成長。常見的例子是二元搜索(Binary search)。

- $O(n)$:執行時間隨資料量呈線性成長,例如在無序的 array 中尋找特定值。

- $O(n \log n)$:執行時間隨資料量呈線性對數成長,常見的合併排序(Mergesort)的複雜度即如斯。

- $O(n^2)$:執行時間隨資料量呈平方成長,例如一些效率不彰的排序法如氣泡排序(Bubble sort)。

- $O(n^3)$:執行時間隨資料量呈立方成長,常見例子為 naïve 實作的矩陣乘法。

- $O(c^n)$:執行時間隨資料量呈指數成長。

- $O(n!)$:執行時間隨資料量呈階乘成長,大部分情況下,這是非常差勁的複雜度。

若想一窺各種常見演算法的複雜度,可以參考這個最全面的 Big-O Cheat Sheet,圖表非常精美直觀!

再次強調,漸進符號也可以代表其他執行成本如記憶體空間,並不一定代表執行時間。

其他的漸進符號還有 little-o、little-omega 等等,有興趣的朋友可以參考文末的資料。

你可能不適合漸進符號

善用漸進符號,可以讓原本複雜艱澀的實際複雜度,簡化至人類容易理解的簡單數學符號,也讓分析演算法效率更為客觀。但實際上,漸進符號省略了常數項與低次項,僅保留最高次項,這種「漸進行為下」的效能表現,在真實世界中,若輸入資料量不夠大,實際複雜度的低次項係數又比高次項大上許多,很可能這個演算法實際上根本沒辦法使用。

另外,漸進符號僅考慮最差與最佳複雜度,沒有考慮到平均複雜度。舉例來說,Quicksort 最差複雜度為 $O(n^2)$,乍看之下不是很理想,但這種情況非常稀少;其平均複雜度落在 $O(n \log n)$,且其係數相對較低,額外開銷少,自然成為最熱門的排序法之一。

還有,漸進符號也沒有考慮到不同語言、平台的基礎操作開銷,例如實作排序法時,有些語言「比較」兩個元素的開銷比「置換」來得大,實作上就需要盡量減少置換元素。同樣的,CPU 快取也非常容易忽略,一些快速的搜尋法很可能因為不是線性搜尋,沒辦法充分利用 CPU cache,效能不一定理想。

總之,漸進符號只能告訴你「當輸入資料量夠大時,演算法的複雜度表現如何」,並不總是適用每個情境,端看你怎麼使用他。

參考資料

- Wiki: Time complexity

- Wiki: Big O notation

- Brilliant: Big O Notation

- Infinite Loop: Complexity Analysis

線性搜尋 Linear Search

線性搜尋,又稱為循序搜尋(sequential search),是一個在序列中找尋目標的方法。正如字面上的意義,線性搜尋會按照順序疊代序列,挨家挨戶比對每個元素與目標值是否相等,若相等則停止疊代,並回傳搜尋所得結果。

線性搜尋乍看之下,是最簡單實作也最 naïve 的實作,效能應該不怎麼好。事實上,在資料量不多時(少於 100 個元素),線性搜尋的效能也不會太差,因為其他搜尋演算法可能需要建立特殊資料結構,就會導致時空間初始開銷暴增,複雜度的常數項成本變大。

效能

| Complexity | |

|---|---|

| Worst | $O(n)$ |

| Best | $O(1)$ |

| Average | $O(n)$ |

| Worst space | $O(1)$ |

若序列中總共有 $n$ 個元素,則線性搜尋最差的狀況為元素不在序列中,就是全部元素都比較一次,共比較 $n - 1$ 次,最差複雜度為 $O(n)$。

實作

線性搜尋就是用一個 for-loop 解決。要注意的是,T 泛型參數至少要實作 PartialEq 才能比較。程式碼中使用了疊代器的 enumerate,建立一個新疊代器,每次疊代產生疊代次數與對應的值。

#![allow(unused)] fn main() { pub fn linear_search<T>(arr: &[T], target: &T) -> Option<usize> where T: PartialEq { for (index, item) in arr.iter().enumerate() { if item == target { return Some(index); } } None } }

事實上,若利用 Rust 內建的 iterator.position,程式碼也許會更簡潔。

#![allow(unused)] fn main() { pub fn linear_search<T>(arr: &[T], obj: &T) -> Option<usize> where T: PartialEq { arr.iter().position(|x| x == obj) } }

參考資料

二元搜尋 Binary Search

Binary search,又稱對數搜尋(logarithmic search),是一個在已排序的序列中,快速找出特定元素的搜尋演算法。二元搜尋的步驟就像玩猜數字,先猜一個數字,告訴你你的猜測比正確答案大或小,再繼續往對的方向猜,捨棄猜錯的另一半。這樣持續進行好幾次猜測,每猜一次,搜尋範圍就縮小一半,因此稱為「二元」搜尋。

二元搜尋有以下幾個特點:

- 概念簡單,搜尋高效,達到對數執行時間 $O(\log n)$。

- 不需額外實作資料結構或配置記憶體空間。

- 只能搜尋已排序的序列。

步驟

- 從序列中間的元素開始,比較其與目標值

- 若該元素為搜尋目標,則結束搜尋。

- 若該元素較大或小,則將序列切一半,往較小或較大的一半搜尋。

- 繼續從一半的序列中間的元素開始,重複步驟一到三,直到欲搜尋的序列為空。

說明

這裡有一個排好序的序列,共有 15 個元素,現在要找尋 9 是否在序列中。

*

[2, 3, 3, 6, 6, 7, 9, 13, 15, 19, 20, 22, 23, 24, 25]

首先,先找到中間的元素 15 / 2 ~= 8,第八個元素為 13,比 9 大,因此捨棄第八個元素之後的所有元素。

*

[2, 3, 3, 6, 6, 7, 9, _, _, _, _, _, _, _, _]

接下來繼續對半搜尋,8 / 2 = 4,找尋第四個元素來比對,6 比 9 小,,因此捨棄第四個元素前的所有元素。

*

[_, _, _, 6, 6, 7, 9, _, _, _, _, _, _, _, _]

對剩下的元素二元搜尋,4 / 2 = 2,並從第四個元素開始計算中點 4 + 2 = 6,取得第六個元素為 7,比 9 小,捨棄 7 之前的元素。

*

[_, _, _, _, _, 7, 9, _, _, _, _, _, _, _, _]

繼續切一半來搜尋,繼續找中間的元素 2 / 2 = 1,並從第六個元素計算索引位置 6 + 1 = 7,查看第七個元素是 9,終於找到了!

效能

| Complexity | |

|---|---|

| Worst | $O(\log n)$ |

| Best | $O(1)$ |

| Average | $O(\log n)$ |

| Worst space | $O(1)$ |

二元搜尋可以透過分治法(Divide and conquer)遞迴求解,而遞迴的終止條件是序列不能在切兩半。由此可知,二元搜尋的複雜度奠基在要切幾次,子序列長度才會等於 1。設 $n$ 為資料數目,$k$ 為要切幾次才會達成終止條件,可得:

$$ \frac{n}{2^k} = 1 $$

接下來同乘 $2^k$ 並取對數。 $$ \frac{n}{2^k} = 1 \\ \Rightarrow 2^k = n \\ $$

再將左式整理一下,得到 $k$。

$$ \log_2 2^k = log_2 n \\ \Rightarrow k \cdot \log_2 2 = log_2 n \\ \Rightarrow k = log_2 n $$

於是,我們得到二元搜尋時間複雜度為 $O(k) = O(\log_2 n) = O(\log n)$。

寫這種式子也許不好理解,我們可以把搜尋過程和每個分支寫成樹狀圖,方便觀察。假設一個數列有七個元素 [1, 2, 3, 4, 5, 6, 7],其二元搜尋所有可能路徑的樹狀圖如下:

+---+

| 4 |

+---+

/ \

+---+ +---+

| 2 | | 6 |

+---+ +---+

/ \ / \

+---+ +---+ +---+ +---+

| 1 | | 3 | | 5 | | 7 |

+---+ +---+ +---+ +---+

樹中每一條路徑都代表任意搜尋會經過的步驟,總共有 7 種不同的搜尋路徑,最短路徑僅需要 $\lfloor{\log_2 n} = 3 \rfloor$ 個操作,也就是需要執行「樹高」次的操作。

實作

函式宣告

二元搜尋概念看似簡單,實際上誤區一堆,不易寫出完全正確的演算法。我們參考 Rust slice binary_search 的實作。先來看看函式宣告的簽名(function signature)。

#![allow(unused)] fn main() { pub fn binary_search<T>(arr: &[T], target: &T) -> Result<usize, usize> where T: PartialOrd }

二元搜尋函式宣告中,回傳值大概是最特別的部分。如果有找到目標元素,Result 會是 Ok(目標索引位置),如果沒有找到則回傳 Err(目標值若插入後,不會影響序列排序的位置)。Err 回傳值提供了插入點,非常方便。

再來,T 泛型參數需是 PartialOrd,這是由於二元搜尋使用排序過後的元素,比起線性搜尋,仍需元素之間相互比較。

函式主體

市面上常見的實作通常以兩個變數 l 與 r 記錄搜尋範圍的上下界,而我們另闢蹊徑,記錄了

base:搜尋範圍的下界,size:搜尋範圍的長度。

以下是完整實作:

#![allow(unused)] fn main() { pub fn binary_search<T>(arr: &[T], target: &T) -> Result<usize, usize> where T: PartialOrd { let mut size = arr.len(); // 1 if size == 0 { return Err(0); } let mut base = 0_usize; while size > 1 { // 2 // mid: [base..size) let half = size / 2; // 2.1 let mid = base + half; if arr[mid] <= *target { // 2.2 base = mid } size -= half; // 2.3 } if arr[base] == *target { // 3 Ok(base) } else { Err(base + (arr[base] < *target) as usize) } } }

- 第一部分先取得搜尋範圍

size以及確定下界為0_usize。這裡同時檢查若序列長度為零,直接回傳Err(0),告知呼叫端可直接在 index 0 新增元素。 - 第二部分就是精髓了,將終止條件設在

size <= 1,以確保迴圈能夠正常結束。- 先將搜尋範圍對半切,再與下界

base相加,算出中點。 - 另中間元素與目標值比較,如果比較小,則移動下界至中點。

- 將

size減半,縮小搜尋範圍。

- 先將搜尋範圍對半切,再與下界

- 到了第三部分,

base已經是切到長度為一的序列了,若匹配目標值就直接回傳;若否,需要傳可供目標值插入的位置,將 bool 判斷是轉型成usize,若arr[base]比目標值小,則目標值要加到其後 +1 位置,反之則加在其前 -1 位置。

常見誤區與解法

-

只適用已排序序列: 這是使用二元搜尋的前提,千萬不能忽略這重要特性,否則後果絕對大錯特錯。

-

處理重複元素:一般的實作通常是回傳任意符合目標值的索引位置,就算有重複的元素,仍然不可預期。若要回傳特定位置(leftmost 或 rightmost),則需特別處理。

-

整數溢位:部分二元搜尋實作會 以兩個變數儲存搜尋範圍上下界的索引位置,而取中點時千萬不可直接將上下界相加再除二,否則很可能整數溢位(integer overflow)。

#![allow(unused)] fn main() { let mid = (end + start) / 2 // Wrong: integer overflow let mid = start + (end - start) / 2 // Correct } -

終止條件錯誤:無論如何實作,請將終止條件設為「搜尋範圍為空」,也就是下界大於上界,而不要只比較上下界是否相等。其實搜尋範圍低於一定長度,即可使用線性搜尋替代,避免處理邊界值的麻煩,實務上也幾乎沒有太多效能損失。

變形與衍生

Interpolation Search

Interpolation search 改良自二元搜尋,差別在於,二元搜尋選擇中間的元素作為二分點,而 interpolation search 人如其名,以內插法找尋二分點。在資料平均分佈時,比二元搜尋更高效。欲知後續,待下回內插搜尋 Interpolation search 分曉。

Exponential Search

Exponential search 是一種特殊的二元搜尋,主要用在搜尋無限、無邊界的已排序序列,由於邊界未知長度就未知,無法以傳統二元搜尋找尋中點。Exponential 顧名思義就是不斷比較在 $2^0$,$2^1$ 直到 $2^n$ 的位置上資料是否比目標值大,若較大,再從該位置執行二元搜尋回頭找。詳情請看指數搜尋 Exponential search。

Binary Insertion Sort

Insertion sort 有一個步驟是在前面已經排完序的資料中,找到適合的地方插入待排序的元素,這部分可透過二元搜尋加快在已排序資料搜尋的速度。詳情請參考 Binary insertion sort。

參考資料

內插搜尋 Interpolation Search

內插搜尋 Interpolation search 為二元搜尋的變種,差別在於二分點的選擇方法,二元搜尋選擇中間的元素作為二分點,而內插搜尋則名副其實,以內插法找尋二分點。內插法有許多種類,本次搜尋演算法選擇使用常見的線性內插(linear interpolation)實作。

內插搜尋的特色如下:

- 資料需要是可計算內插(interpolation)的數值資料。

- 對資料分佈敏感,資料均勻分佈時,效能勝過二元搜尋。

- 資料分佈不均勻時,最差複雜度高達 $O(n)$。

步驟

- 確認資料已經排好序。

- 利用第一個元素 a 與最後的元素 b,以及搜尋上下界 hi 與 lo 位置,作為兩個端點。

- 利用上述兩點 (lo, a) 與 (hi, b),對搜尋目標計算內插,得到可能的位置。

- 若該位置上元素較小,則令其為新搜尋下界 a’,重複步驟二到三,繼續求內插。

- 若該位置上元素較大,則令其為新搜尋上界 b’,重複步驟二到三,繼續求內插。

- 若相等,則完成搜尋。

- 搜尋停止在 a’、b’ 兩元素搜尋位置重疊,以及目標值比下界 a’ 小或比上界 b’ 大。

說明

迅速說明線性內插法。線性內插法是中學必修的數學概念,給定兩點 $(x_0,y_0)$ 與 $(x_1,y_1)$,欲求在 $[x_0,x_1]$ 區間內直線上 $x’$ 點的 y 值,可以透過斜率公式求解:

$$ \frac{y - y_0}{x’ - x_0} = \frac{y_1 - y_0}{x_1 - x_0 } $$

接下來就是小學解方程式的事兒了。

Cmglee - CC BY-SA 3.0

回到正題,以下用文字解釋內插搜尋。

這裡有一個已排序有 14 個元素的序列,我們需要從中找出 27。

[1, 9, 10, 15, 17, 17, 18, 23, 27, 28, 29, 30, 31, 34]

我們將序列索引當作 x 軸,元素值作為 y 軸。可得已知兩點為 $(0, 1)$ 及 $(13, 34)$。

首先,透過斜率公式,計算出在 $y = 27$ 時,$x’$,也就是 27 在序列中可能的位置為

$$x’ = \lfloor 27 / (34 - 1) \cdot (13 - 0) \rfloor = 10$$

查看 arr[10] 為 29,比搜尋目標 27 來得大。將 29 當作我們新的上界,搜尋範變成第 [0, 9] 個元素(29 不需列入搜尋),繼續計算內插

$$x’ = \lfloor 27 / (28 - 1) \cdot (9 - 0) \rfloor = 9$$

查看 arr[9] 為 28,比搜尋目標 27 來得大。將 28 當作我們新的上界,搜尋範變成第 [0, 8] 個元素(28 不需列入搜尋),繼續計算內插

$$x’ = \lfloor 27 / (27 - 1) \cdot (8 - 0) \rfloor = 8$$

查看 arr[8] 為 27,恰恰是搜尋目標 27,搜尋到此結束。

效能

| Complexity | |

|---|---|

| Worst | $O(n)$ |

| Best | $O(1)$ |

| Average | $O(n)$ |

| Average | $O(\log \log n)$ on uniform distributed data |

| Worst space | $O(1)$ |

$n$:資料筆數

線性內差搜尋的最差時間複雜度為 $O(n)$,也就是每次內差的結果都落在邊界旁,搜尋範圍只縮小一個元素。這種情況容易發生在資料依排序呈指數或對數等非線性函數。例如 $y = 2^x$。

線性內插搜尋對資料的期望是均勻機率分佈(uniform probability distribution)。想求平均時間複雜度 $O(\log \log n)$ ,須先透過機率密度函數,計算條件機率,一步步縮小範圍,求得平均誤差,最後求得期望值。這部分計算較為複雜,有興趣的朋友可以參考閱讀資料「Perl, Y., Itai, A., & Avni, H. (1978). Interpolation search—a log log N search.」。

PDF of uniform distribution by IkamusumeFan - CC BY-SA 3.0

實作

內插搜尋的實作共分為幾部分:

- 處理空序列狀況。

- 建立迴圈疊代共用的變數。

- 計算線性插值的主要迴圈。

- 將內插值映射到結果的

Result。

首先是函式宣告。

#![allow(unused)] fn main() { pub fn interpolation_search( arr: &[i32], target: &i32, ) -> Result<usize, usize> }

映入眼簾的是 i32,而非泛型參數,為什麼呢?是因為內插搜尋為了計算線性內插,資料僅限定在「數值資料」,而 Rust 並沒有特別一類 Numeric 的型別,自己透過 trait 實作又異常繁瑣,因此先以 i32 代替。而回傳值的部分,與指數搜尋/二元搜尋一模一樣,回傳的 Result

- 若為

Ok,其值代表目標值在序列內的索引位置; - 若為

Err,則是可以將目標值插入序列內又不會破壞排序的位置。

延續數值型別的話題,Rust 社群提供 num crate,定義了各種數值型別與 trait,大整數、複數、虛數、有理數都囊括其中,非常有趣。

再來就是第一第二部分,處理空序列與建立共用變數,非常直觀。

#![allow(unused)] fn main() { if arr.is_empty() { return Err(0) } let mut hi = arr.len() - 1; let mut lo = 0_usize; let mut interpolant = 0_usize; }

hi、lo兩個變數劃定的搜尋範圍上下界。interpolant儲存線性插值,代表每次疊代的搜尋位置。

接下來就是主要的迴圈,負責疊代計算內插值。分為三個部分,直接看程式碼先。

#![allow(unused)] fn main() { loop { let lo_val = arr[lo]; let hi_val = arr[hi]; // 1. if hi <= lo || *target < lo_val || *target > hi_val { break } // 2. The linear interpolation part let offset = (*target - lo_val) * (hi - lo) as i32 / (hi_val - lo_val); interpolant = lo + offset as usize; let mid_val = arr[interpolant]; // 3. if mid_val > *target { hi = interpolant - 1; } else if mid_val < *target { lo = interpolant + 1; } else { break } } }

- 迴圈的三個終止條件,分別為:

hi、lo兩個變數劃定的搜尋範圍重疊,長度為零。- 搜尋目標值比上界還大。

- 搜尋目標值比下界還小。

- 線性內插的計算方程式,要注意我們是寫 Rust 不是 JavaScript,

i32與usize不能混用,要手動轉型。 - 比較插值與目標值。相等則跳出迴圈;若目標大於小於插值,則縮小搜尋範圍。注意,範圍需手動加減一,排除上下界,以免無限迴圈產生。

最後一部分則是決定線性插值所得的索引位置是否為目標值,並將該值映射到 Result 上。

#![allow(unused)] fn main() { if *target > arr[hi] { Err(hi + 1) } else if *target < arr[lo] { Err(lo) } else { Ok(interpolant) } }

完整的程式碼如下。

#![allow(unused)] fn main() { pub fn interpolation_search( arr: &[i32], target: &i32, ) -> Result<usize, usize> { // 1. Handle empty sequence. if arr.is_empty() { return Err(0) } // 2. Setup variable storing iteration informaion. let mut hi = arr.len() - 1; let mut lo = 0_usize; let mut interpolant = 0_usize; // 3. Main loop to calculate the interpolant. loop { let lo_val = arr[lo]; let hi_val = arr[hi]; // 3.1. Three condition to exit the loop if hi <= lo || *target < lo_val || *target > hi_val { break } // 3.2. The linear interpolation part let offset = (*target - lo_val) * (hi - lo) as i32 / (hi_val - lo_val); interpolant = lo + offset as usize; let mid_val = arr[interpolant]; // 3.3. Comparison between the interpolant and targert value. if mid_val > *target { hi = interpolant - 1; } else if mid_val < *target { lo = interpolant + 1; } else { break } } // 4. Determine whether the returning interpolant are equal to target value. if *target > arr[hi] { Err(hi + 1) } else if *target < arr[lo] { Err(lo) } else { Ok(interpolant) } } }

變形與衍生

Interpolation Search Tree

Interpolation search tree(IST),姑且稱它「內插搜尋樹」,是一個將內插搜尋結合樹的資料結構。如上述提及,內插搜尋達到 $O(\log \log n)$ 的搜尋時間,但僅適用於均勻機率分佈的資料。而 IST 利用動態內插搜尋,讓 1)內插搜尋樹的搜尋可以使用在更多元的規律機率分佈的資料中,且 2)可以達到以下的執行效能:

- $O(n)$ 空間複雜度。

- 預期有 $O(\log \log n)$ 的平攤增減節點操作時間,最差有 $(O \log n)$。

- 在規律分佈的資料中,預期搜尋時間為 $O(\log \log n)$,最差時間複雜度則為 $O((\log n)^2)$

- 線性時間的循序存取,而取得前後節點或最小值都是常數時間。

更多詳細證明可以閱讀參考資料「Andersson, A. (1996, October). Faster deterministic sorting and searching in linear space」。

參考資料

- Wiki: Interpolation search

- Perl, Y., Itai, A., & Avni, H. (1978). Interpolation search—a log log N search. Communications of the ACM, 21(7), 550-553.

- Andersson, A. (1996, October). Faster deterministic sorting and searching in linear space. In Foundations of Computer Science, 1996. Proceedings., 37th Annual Symposium on (pp. 135-141). IEEE.

- Linear interpolation visualisation SVG By Cmglee CC BY-SA 3.0, via Wikimedia Commons.

- Probability density function of uniform distribution SVG By IkamusumeFan CC BY-SA 3.0, via Wikimedia Commons.

指數搜尋 Exponential Search

指數搜尋,又稱為 galloping search,是一種特殊的二元搜尋,主要用在搜尋無限、無邊界的已排序序列。由於邊界未知長度就未知,無法以傳統二元搜尋來找中點。而 Exponential 顧名思義就是從底數為 2,指數為 0 的索引($2^0$ )開始,不斷比較在 $2^1$、$2^2$ 直到 $2^k$ 位置上的值,若比目標值大,則停止指數成長,直接從該位置執行二元搜尋,回頭尋找目標值。

指數搜尋的特點如下:

- 可以搜尋邊界未知的已排序序列。

- 縮小搜尋範圍,可比 naïve 的二元搜尋效率高些。

- 若目標值實際位置很靠近序列前端,效率會非常棒。

步驟

指數搜尋的步驟只有非常簡單的兩步驟:

- 依照目標值大小,劃出搜尋範圍。

- 在上述範圍內執行二元搜尋。

而劃出搜尋範圍這部分也很直觀:

- 選定一個底數 $k$,通常為 2。

- 比較 $k^i$ 索引下的值是否比目標值大,$i$ 從零開始。

- 若較小,指數加一 $k^{i + 1}$ 後繼續重複步驟二比較。

- 若較大,停止比較,得搜尋範圍為 $k^{i - 1}$ 到 $k^i$。

說明

這裡有個排好序的序列,我們要尋找其中是否有 22 這個數字。

*

[2, 3, 3, 6, 6, 7, 9, 13, 15, 19, 20, 22, 23, 24, 25]

首先,先尋找 $2^0 = 1$ 位置上的數字是否超過 22。3 < 22,很明顯沒有。

* * *

[2, 3, 3, 6, 6, 7, 9, 13, 15, 19, 20, 22, 23, 24, 25]

再來,連續看看

- $2^1$:

3 < 22 - $2^2$:

6 < 22 - $2^3$:

15 < 22

也都沒有超越 22。

*

[2, 3, 3, 6, 6, 7, 9, 13, 15, 19, 20, 22, 23, 24, 25] _, _

最後,一口氣將指數加到 4,看看$2^4$ 上的數字是否大於 22。哎呀,$2^4 = 16$,的位置已經超出序列長度,因此取至序列最後一個數字作為比較對象。25 > 22,找到了!

得到搜尋的範圍是 $$2^{4-1} < x < \text{array.length} < 2^{4}$$

效能

| Complexity | |

|---|---|

| Worst | $O(\log i)$ |

| Best | $O(1)$ |

| Average | $O(\log i)$ |

| Worst space | $O(1)$ |

$i$:目標值在序列中實際的索引位置。

指數搜尋的複雜度分為兩部分分析:

劃定搜尋範圍

設 $i$ 為目標值在序列中實際的索引位置,則搜尋上界,指數增加的操作需執行 $\lceil \log(i) \rceil$ 次,例如匹配目標值的搜尋結果位於序列第 9 個,則指數需增加 $\lceil \log(9) \rceil = 4$ 次,上界才會超過目標值。我們設這部分的複雜度為 $O(log i)$。

執行二元搜尋

第二部分就是二元搜尋,複雜度為 $O(log n)$,$n$ 為搜尋範圍的長度。根據第一部分,可以得知範圍長度為 $2^{\log i} - 2^{\log{i - 1}} = 2^{log{i - 1}}$ 個元素,帶入二元搜尋的複雜度,計算出第二部分的複雜度為 $log (2^{\log{i - 1}}) = \log{(i)} - 1 = O(\log i)$。

最後,將兩部分的複雜度合起來,就是指數搜尋的時間複雜度了。

$$O(\log i) + O(\log i) = 2 O(\log i) = O(\log i)$$

實作

本次實作有邊界的指數搜尋,主要分為三個部分:

- 處理空序列的狀況。

- 利用指數,決定搜尋範圍。

- 執行二元搜尋,並將輸出結果映射回原始序列。

話不多說,直接看程式碼。

#![allow(unused)] fn main() { use crate::searching::binary_search; pub fn exponential_search<T>(arr: &[T], target: &T) -> Result<usize, usize> where T: PartialOrd { // 1. Handle empty scenario. let size = arr.len(); if size == 0 { return Err(0); } // 2. Determine searching boundaries. let mut hi = 1_usize; // Upper bound. while hi < size && arr[hi] < *target { hi <<= 1; } let lo = hi >> 1; // Lower bound. // 3. Do binary search. binary_search(&arr[lo..size.min(hi + 1)], target) .map(|index| lo + index) .map_err(|index| lo + index) } }

- 和二元搜尋同,遇到空序列就返回

Err(0)告知呼叫端可新增資料在位置 0。 - 決定搜尋上下界,只要 上界不超過序列長度,且

arr[hi]小於目標值,就讓上界指數成長。這裡用位元左移運算子(bitwise left shift)實作乘以 2。

找到上界後,再將上界除以 2(位元右移),就是下界了。 - 確定範圍後,利用上下界切序列的 sub slice 作為引數,傳遞給二元搜尋。要注意的是,為了避免 sub slice 超出邊界,上界需在

size與hi + 1之間找最小值。

由於回傳結果的位置是以 sub slice 起始,需加上位移量(下界lo)才會對應原始 slice 的位置。

由於內部使用二元搜尋,若該二元搜尋沒有處理重複元素的狀況,指數搜尋連帶無法預期這個行為。

參考資料

插入排序 Insertion Sort

Insertion sort 是最簡單的排序法之一,比起 quicksort 等高效的排序法,對大資料的處理效能較不理想。其演算法是將欲排序元素直接插入正確位置,因而得名。

Insertion sort 基本特性如下:

- 實作簡單易理解。

- 資料量少時較高效,且比其他 $O(n^2) $ 的排序法高效(selection sort/bubble sort)。

- 自適應排序:可根據當前資料排序情形加速排序,資料越接近排序完成,效率越高。

- 穩定排序:相同鍵值的元素,排序後相對位置不改變。

- 原地排序:不需額外花費儲存空間來排序。

- 即時演算法:可處理逐步輸入的資料,不需等資料完全備妥。

步驟

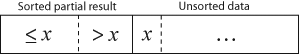

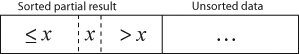

將序列分為未排序與部分排序兩個區域。

- 取第一個元素,將該元素視為已排序。

- 取出下一元素,該元素將插入序列的部分排序區域。

- 尋找正確位置:若部分排序元素比新元素大,則互換位置。並重複步驟 2 - 3,直到部分排序元素小於等於新元素。

- 插入元素:將新元素插入最後的位置。

- 重複步驟 2 - 4,直到排序完成。

簡而言之,即是每次取一個元素,尋找並插入該元素在部分排序區域的排序位置,再逐步把序列單邊排序完成。

Insertion sort 非常簡單,看動畫就能明瞭。

效能

| Complexity | |

|---|---|

| Worst | $O(n^2) $ |

| Best | $O(n) $ |

| Average | $O(n^2) $ |

| Worst space | $O(1) $ auxiliary |

最佳時間複雜度發生在資料已完成排序的狀況下,insertion sort 只需執行最外層的迴圈 $n $ 次。

最差時間複雜度發生在資料完全相反時,insertion sort 每取得一個新元素是,都需將資料插入序列最前面,,因此所需的操作如下( $c $ 為任意常數):

$$ c \cdot 1 + c \cdot 2 + c \cdot 3 \cdots + c \cdot (n - 1) = \frac{c(n - 1 + 1)(n - 1)}{2}$$

最後等於

$$\frac{cn^2}{2} - \frac{cn}{2}$$

捨去低次項,得到時間複雜度為 $O(n^2) $。

實作

簡單實作的程式碼如下:

#![allow(unused)] fn main() { pub fn insertion_sort(arr: &mut [i32]) { for i in 1..arr.len() { // 1 let mut j = i; while j > 0 && arr[j - 1] > arr[j] { // 2 arr.swap(j - 1, j); j -= 1; } } } }

- 外層迴圈疊代整個序列。並取出 index

i,arr[i]是待排序的元素,index 比i小的元素則組成已排序的部分序列。 - 內層迴圈負責元素比較,決定待排序元素該從何處插入,若前一個元素比待排元素大,則置換兩元素,並繼續往下尋找正確的插入點。直到

j == 0或待排元素比任何已排序元素都大為止。

變形

Binary Insertion Sort

在一般演算法討論中,通常以簡單的型別如 i32 來探討並實作。在真實世界中,做哪種操作,用哪種語言,都會影響到實際效能。例如 Python 的比較操作相對於置換元素,成本高出不少,是因為每個物件在 Python 的比較需動態檢查是否實作 __lt__ __gt__ 等方法才能進行比較。所以 Python 排序法實作就要特別注意減少比較操作的次數。

Binary insertion sort 的目的就是減少內層迴圈的比較次數。在內層迴圈開始之前,使用 binary search 搜尋新元素應要插入哪個位置,最多僅需 $\log_2n $ 次比較。但 binary insertion sort 的複雜度依舊是 $O(n^2) $,因為除了比較之外,仍需置換(swap)、賦值(assign)等基礎操作。

Binary insertion sort 的程式碼和一般的 insertion sort 差不了多少,我們這裡使用 slice 內建的 binary_search 來找尋插入點。

#![allow(unused)] fn main() { pub fn binary_insertion_sort(arr: &mut [i32]) { for i in 1..arr.len() { let val = arr[i]; let mut j = i; let pos = match arr[..i].binary_search(&val) { // 1 Ok(pos) => pos, // 2 Err(pos) => pos, }; while j > pos { // 3 arr.swap(j - 1, j); j -= 1; } } } }

- 先限制

binary_search範圍,取出 sorted pilearr[..i]。再對 slice 執行binary_search。 binary_search回傳一個Result<usize, usize>型別,找到時回傳Ok(index 值),找無時回傳Err(不影響排序穩定度的插入點),這個Err的設計巧妙解決新值插入的問題。- 和普通 insertion sort 雷同,從插入點至 sorted pile 疊代到末端以進行排序,省下不少比較操作。

參考資料

- Wiki: Insertion sort

- CPython: listsort note

- Sorting GIF by Swfung8 (Own work) CC BY-SA 3.0 via Wikimedia Commons.

選擇排序 Selection sort

Selection sort 是最易實作的入門排序法之一,會將資料分為 sorted pile 與 unsorted pile,每次從 unsorted pile 尋找最大/最小值,加入 sorted pile 中。

Selection sort 的特性如下:

- 最簡單的排序法之一。

- 對小資料序列排序效率較高。

- 不穩定排序:排序後,相同鍵值的元素相對位置可能改變。

- 原地排序:不需額外花費儲存空間來排序。

步驟

- 將資料分為 sorted pile 與 unsorted pile。

- 從 unsorted pile 尋找最小值。

- 置換該最小值元素與 unsorted pile 第一個元素。

- 重複步驟 2 - 3,直到排序完成。

注意,這個 naïve 的 selection sort 實作為不穩定排序。

Joestape89 - CC BY-SA 3.0

說明

為什麼 naïve 的 selection sort 會是不穩定排序?

假定有一個序列要遞增排序,其中有重複的 2 元素,我們將其標上 2a、2b 以利辨識。

[2a, 3, 4, 2b, 1]

開始疊代找出最小值並指環。

* *

[1, 3, 4, 2b, 2a] # 1. 置換 2a, 1

* *

[1, 2b, 4, 3, 2a] # 2. 置換 3, 2b

* *

[1, 2b, 2a, 3, 4] # 3. 置換 4, 2a

有沒有發現,2a 與 2b 的相對順序顛倒了呢?

首先,回想一下穩定排序的定義:相同鍵值的元素,排序後相對位置不改變。

問題出在 naïve selection sort 是以置換的方式排序每次疊代的最小值。若我們將置換(swap)改為插入(insert),那麼 selection sort 就會是穩定排序,但相對地,需要位移剩餘未排序的元素,除非使用 linked list 或其他提供 $O(1) $ insertion 的資料結構,不然就會多出額外 $O(n^2) $ 的寫入成本。

效能

| Complexity | |

|---|---|

| Worst | $O(n^2) $ |

| Best | $O(n^2) $ |

| Average | $O(n^2) $ |

| Worst space | $O(1) $ auxiliary |

對於接近排序完成的序列,selector sort 並無法有自適應的方式加快排序疊代。第一個元素要做 $n - 1 $ 次比較,第二個 $n - 2 $ 次,總比較次數如下:

$$ (n -1) + (n-2) + \cdots + 1 = \sum_{i=1}^{n-1} i = \frac{n(n - 1)}{2}$$

因此無論序列是否排序完成,selection sort 仍需執行 $n^2 $ 次比較,時間複雜度為 $O(n^2) $。

實作

簡單實作如下:

#![allow(unused)] fn main() { pub fn selection_sort(arr: &mut [i32]) { let len = arr.len(); for i in 0..len { // 1 let mut temp = i; for j in (i + 1)..len { // 2 if arr[temp] > arr[j] { temp = j; } } arr.swap(i, temp); // 3 } } }

- 外層迴圈負責儲存當前要排序的 index

i的位置。 - 內層迴圈負責在 unsorted pile 範圍 [

i,len) 找最小值。 - 外層迴圈在找到最小值之後,置換兩元素。

眼尖的人會發現,內外兩層迴圈的 upper bound 都是 len,這樣是否內側迴圈會 out of bound?Rust 的 range operator(core::ops::Range)實作 Iterator trait 時,有檢查 range.start < range.end,因此這個寫法並不會有出界問題,但會多跑一次無意義的疊代。

變形

Heapsort

Heapsort 是一個高效的排序法,使用 selection sort 融合 heap 這種半排序的資料結構,讓時間複雜度進化至 $O(n \log n) $。更多詳情可以參考這篇介紹。

參考資料

- Wiki: Selection sort

- Why Selection sort can be stable or unstable

- Sorting GIF by Joestape89 CC BY-SA-3.0 via Wikimedia Commons.

氣泡排序 Bubble sort

Bubble sort 是最簡單的排序法之一,由於排序時每個元素會如同泡泡般,一個一個浮出序列頂部,因而得名。由於其簡單好理解,名稱又有趣,常作為第一個學習的入門排序法。不過其效率不彰,甚至不如同為 quardratic time 的 insertion sort。Bubble sort 的原理很平凡,就是相鄰兩兩元素互相比較,如果大小順序錯了,就置換位置。再往下一個 pair 比較。

Bubble sort 的特性如下:

- 又稱為 sinking sort。

- 穩定排序:相同鍵值的元素,排序後相對位置不改變。

- 原地排序:不需額外花費儲存空間來排序。

步驟

- 比較兩個相鄰元素,若首個元素比次個元素大,置換兩者的位置。

- 依序對相鄰元素執行步驟一,直到抵達序列頂端,此時頂端元素排序完成。

- 重複步驟 1 - 2 的整個序列疊代,直到任何一次疊代沒有執行元素置換。

Swfung8 - CC BY-SA 3.0

Swfung8 - CC BY-SA 3.0

說明

給定一組序列 [5, 3, 8, 7, 2],以 bubble sort 遞增排序。以 ASCII diagram 表示:

第一次疊代

* * * *

[5, 3, 8, 7, 4] -> [3, 5, 8, 7, 4] # 置換 3 與 5

* * * *

[3, 5, 8, 7, 4] -> [3, 5, 8, 7, 4] # 不需置換

* * * *

[3, 5, 8, 7, 4] -> [3, 5, 7, 8, 4] # 置換 7 與 8

* * * *

[3, 5, 7, 8, 4] -> [3, 5, 7, 4, 8] # 置換 4 與 8,8 已排好序

第二次疊代

* * * *

[3, 5, 7, 4, 8] -> [3, 5, 7, 4, 8] # 不需置換

* * * *

[3, 5, 7, 4, 8] -> [3, 5, 7, 4, 8] # 不需置換

* * * *

[3, 5, 7, 4, 8] -> [3, 5, 4, 7, 8] # 置換 4 與 7

* * * *

[3, 5, 4, 7, 8] -> [3, 5, 4, 7, 8] # 不需置換

naïve bubble sort 會跑完整個序列,即是已排序完成。

第三次疊代

* * * *

[3, 5, 4, 7, 8] -> [3, 5, 4, 7, 8] # 不需置換

* * * *

[3, 5, 4, 7, 8] -> [3, 4, 5, 7, 8] # 置換 4 與 5

* * * *

[3, 5, 4, 7, 8] -> [3, 4, 5, 7, 8] # 不需置換

* * * *

[3, 5, 4, 7, 8] -> [3, 4, 5, 7, 8] # 不需置換

第四次疊代

* * * *

[3, 4, 5, 7, 8] -> [3, 4, 5, 7, 8] # 不需置換

* * * *

[3, 4, 5, 7, 8] -> [3, 4, 5, 7, 8] # 不需置換

* * * *

[3, 4, 5, 7, 8] -> [3, 4, 5, 7, 8] # 不需置換

* * * *

[3, 4, 5, 7, 8] -> [3, 4, 5, 7, 8] # 不需置換

很簡單的排序法!

效能

| Complexity | |

|---|---|

| Worst | $O(n^2) $ |

| Best | $O(n) $ |

| Average | $O(n^2) $ |

| Worst space | $O(1) $ auxiliary |

Time complexity

Bubble sort 總共需要 $n - 1 $ 次疊代,每次疊代至少需要執行 $n - 1 - i $ 置換( $i $ 為第幾次疊代),總共需要疊代

$$\sum_{i=0}^{n-1} (n - i - 1) = n^2 - \sum_{i=0}^{n-1}i - n = n^2 - \frac{n(n - 1)}{2} - n = \frac{n^2}{2} - \frac{n}{2}$$

次,因此,時間複雜度為 $O(n^2) $。

Bubble sort 在已排序完成的序列上,只需要疊代序列一次,發現完全沒有置換任何元素,即停止排序,可達到最佳時間複雜度。

實作

Bubble sort 簡單實作如下:

#![allow(unused)] fn main() { pub fn bubble_sort(arr: &mut [i32]) { let mut swapped = true; // 1 while swapped { swapped = false; for i in 1..arr.len() { // 2 if arr[i - 1] > arr[i] { arr.swap(i - 1, i); swapped = true // 3 } } } } }

- 建立一個旗標,標誌該次疊代是否有元素置換。

- 內層迴圈依序比較兩兩相鄰元素。

- 若有任何置換動作,將旗標標誌為「已置換(

true)」。

倘若記錄已排好序的元素位置,雖然複雜度仍是 $O(n^2) $,但如此以來,每次疊代都可少一次元素比較,對比較操作成本高的語言或實作來說,仍不失為最佳化的方法。程式碼如下:

#![allow(unused)] fn main() { pub fn bubble_sort_optimized(arr: &mut [i32]) { let mut new_len: usize; let mut len = arr.len(); // 1 loop { new_len = 0; for i in 1..len { if arr[i - 1] > arr[i] { arr.swap(i - 1, i); new_len = i; // 2 } } if new_len == 0 { // 3 break; } len = new_len; // 4 } } }

- 將當前的序列長度記錄到

len。 - 內層迴圈負責比較、置換,以及記錄未排序部分的序列長度到

new_len。 - 若未排序部分

new_len為零,代表排序完成。 - 外層迴圈將新長度值

new_len賦予len,下一次疊代就可少做一次比較。

參考資料

- Wiki: Bubble sort

- Sorting GIF was created by Swfung8 (Own work) CC BY-SA 3.0 via Wikimedia Commons.

希爾排序 Shellsort

眾所周知,Insertion sort 用在幾乎完成排序的序列上非常高效,換句話說,當元素置換不需移動太遠時,效率很高。反之,如果有元素錯位非常遙遠,效能就會大打折扣。Shellsort 以一個 gap sequence 將資料依指定的間隔(gap)分組進行 insertion sort,使得較遠的元素能夠快速歸位,下一次的排序就會因前次排序結果愈來愈接近完成而加速。

Shellsort 最後一個 gap 必定是 1,也就是排序會退化成 insertion sort,此時大部分元素皆排序完成,insertion sort 會非常高效。

Shellsort 特性如下:

- 自適應排序:可根據當前資料排序情形加速排序,資料越接近排序完成,效率越高。

- 不穩定排序:排序後,相同鍵值的元素相對位置可能改變。

- 原地排序:不需額外花費儲存空間來排序。

- 可視為一般化(Generalizaion)的 insertion sort。

步驟

Shellsort 分為兩個步驟:

- 決定一組 gap sequence。

- 疊代 gap sequence 進行分組排序,每次執行有間隔的 insertion sort。也就是每個元素與其相鄰 gap 的元素比較與置換。

最後一次排序(gap = 1)會退化為 insertion sort,完成整個排序。

Gap Sequneces

Shellsort 的效率取決於 gap sequence 的選擇,這邊舉幾個常見的 gap sequence:

| Sequence | |

|---|---|

| Marcin Ciura | 1, 4, 10, 23, 57, 132, 301, 701 |

| $2^{k} - 1 $ | 1, 3, 7, 15, 31, 63,… |

| $\lfloor {\frac {N}{2^k}} \rfloor $ | $\lfloor {\frac {N}{2}} \rfloor $, $\lfloor {\frac {N}{4}} \rfloor $, …, 1 |

感受一下 gap sequence 為 23, 10, 4, 1 的 shellsort 吧。

說明

Shellsort 其實就是進行好幾次不同 gap 的 insertion sort,以下用 ASCII diagram 解釋。

假定這裡有一個序列需要遞增排序。

[5, 3, 8, 7, 4, 9, 6, 2]

我們選擇最簡單的 $\lfloor {\frac {N}{2^k}} \rfloor $ gap sequence 來排序。我們以星號標示出每次 insertion sort 對應排序

首先算出第一個 gap 為 $8 / 2^1 = 4 $。開始 insertion sort。

* *

[5, 3, 8, 7, 4, 9, 6, 2]

-> (sort subsequence [5, 4])

* *

[4, 3, 8, 7, 5, 9, 6, 2]

-> (skip)

* *

[4, 3, 8, 7, 5, 9, 6, 2]

-> (sort subsequence [8, 6])

* *

[4, 3, 6, 7, 5, 9, 8, 2]

-> (sort subsequence [7, 2])

[4, 3, 8, 2, 5, 9, 6, 7]

再來算出第二個 gap 為 $8 / 2^2 = 2 $。開始 insertion sort。

* *

[4, 3, 8, 2, 5, 9, 6, 7]

-> (skip)

* *

[4, 3, 8, 2, 5, 9, 6, 7]

-> (sort subsequence [3, 2])

* * *

[4, 2, 8, 3, 5, 9, 6, 7]

-> (sort subsequence [4, 8, 5])

* * *

[4, 2, 5, 3, 8, 9, 6, 7]

-> (skip)

* * * *

[4, 2, 5, 3, 8, 9, 6, 7]

-> (sort subsequence [4, 5, 8, 6])

* * * *

[4, 2, 5, 3, 6, 9, 8, 7]

-> (sort subsequence [2, 3, 9, 7])

[4, 2, 5, 3, 6, 7, 8, 9]

再來進行第三次排序。gap 為 $8 / 2^3 = 1 $,shellsort 退化至 insertion sort,但前一次結果已經很接近排序完成,insertion sort 可以幾乎在 one pass 完成排序。

Insertion sort 的 ASCII diagram 我們就不展示了,請參考 Insertion sort。

效能

| Complexity | |

|---|---|

| Worst | $O(n^2) $ ~ $O(n \log^2 n) $ (Depends on gap sequence) |

| Best | $O(n \log n) $ |

| Average | Depends on gap sequence |

| Worst space | $O(1) $ auxiliary |

Shellsort 的複雜度不容易計算,取決於 gap sequence 怎麼安排,太少 gap 會讓速度太接近 insertion sort,太多 gap 則會有過多額外開銷。目前已知的 gap sequence 中,最差時間複雜度可以達到 $O(n \log^2 n) $,有著不錯的表現。有興趣可以參考這篇文章。

實作

我們這裡以 Marcin 的 Paper 中提到的經驗式為例,首先,先建立一個 gap sequence 的常數。

#![allow(unused)] fn main() { /// Marcin Ciura's gap sequence. pub const MARCIN_GAPS: [usize; 8] = [701, 301, 132, 57, 23, 10, 4, 1]; }

再來就是主程式的部分,總共會有三個迴圈,

- 最外層是疊代 gap sequence,

- 中間層是疊代整個資料序列,

- 內層就是每個元素的插入排序動作。

#![allow(unused)] fn main() { /// Shellsort pub fn shellsort(arr: &mut [i32]) { let len = arr.len(); for gap in MARCIN_GAPS.iter() { // 1 let mut i = *gap; // 4 while i < len { // 2 let mut j = i; while j >= *gap && arr[j - gap] > arr[j] { // 3 arr.swap(j - *gap, j); j -= *gap; } i += 1; } } } }

- 最外層的迴圈,利用

iter()trait 產生疊代器,疊代 gap sequence。 - 中間層迴圈,控制

i是否超出資料序列,以疊代整合資料序列。 - 最內層迴圈,執行插入動作,將每個元素置換到正確位置。

- 由於

gap的型別是&usize,需透過*gapdereference 得到usize型別。

參考資料

- Wiki: Shellsort

- Best Increments for the Average Case of Shellsort, M. Ciura, 2001

- Shellsort and Sorting Networks (Outstanding Dissertations in the Computer Sciences)

堆積排序 Heapsort

Heapsort(堆積排序)可以看作是 selection sort 的變形,同樣會將資料分為 sorted pile 與 unsorted pile,並在 unsorted pile 中尋找最大值(或最小值),加入 sorted pile 中。

和 selection sort 不同之處是,heapsort 利用堆積(heap)這種半排序(partially sorted)的資料結構輔助並加速排序。

Heapsort 的特性如下:

- 使用 heap 資料結構輔助,通常使用 binary heap。

- 不穩定排序:排序後,相同鍵值的元素相對位置可能改變。

- 原地排序:不需額外花費儲存空間來排序。

- 較差的 CPU 快取:heap 不連續存取位址的特性,不利於 CPU 快取。

步驟

Heapsort 的演算法分為兩大步驟:

- 將資料轉換為 heap 資料結構(遞增排序用 max-heap, 遞減排序選擇 min-heap)。

- 逐步取出最大/最小值,並與最後一個元素置換。具體步驟如下:

- 交換 heap 的 root 與最後一個 node,縮小 heap 的範圍(排序一筆資料,故 heap 長度 -1)。

- 更新剩下的資料,使其滿足 heap 的特性,稱為 heap ordering property。

- 重複前兩個步驟,直到 heap 中剩最後一個未排序的資料。

透過 GIF 動畫感受一下 heapsort 的威力吧!

說明

在開始之前,定義幾個 heap 常用名詞:

- Heap ordering property:一個 heap 必須要滿足的條件。以 heap 種類不同有幾種變形。

- min-heap property:每個結點皆大於等於其父節點的值,且最小值在 heap root。

- max-heap property:每個結點皆小於等於其父節點的值,且最大值在 heap root。

而 heapsort 主要分為兩個部分:

- Heapify:將陣列轉換為 heap 資料結構(heapify)。

- Sorting:不斷置換 heap root 與最後一個元素來排序,並修正剩餘未排序資料使其符合 heap order。

這裡有一個未排序的序列,將以遞增方向排序之。

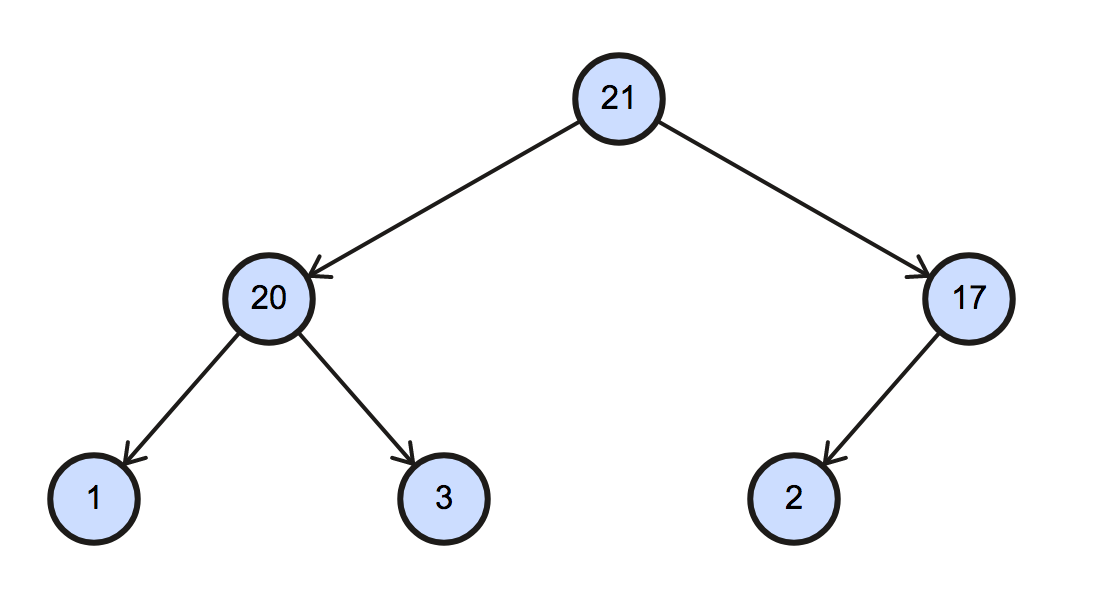

[17, 20, 2, 1, 3, 21]

首先,將資料轉換為 heap 資料結構,這個步驟即時 heapify。由於是遞增排序,我們採用 max-heap(最大元素在 root)。

[21, 20, 17, 1, 3, 2]

對應的二元樹(binary tree)的圖形如下:

再來就是排序的部分,Max-heap 會將最大的元素擺在 root 的位置,我們先將最後一個 node 與 root 進行交換,完成第一個排序步驟。

若不熟悉 heap,可以閱讀 Wiki 的介紹,其實 heap 就是用陣列實作的二元樹。

[21, 20, 17, 1, 3, 2]

* *

(swap) -->

unsorted | sorted

[2, 20, 17, 1, 3 | 21]

接下來,將未排序的資料區塊重整為符合 max-heap 的結構。

[2, 20, 17, 1, 3 | 21]

(sift down) -->

[20, 3, 17, 1, 2 | 21]

有沒有看出一些端倪?

只要不斷將 root 和最後一個 node 交換,並將剩餘資料修正至滿足 heap ordering,就完成排序了。

[20, 3, 17, 1, 2 | 21]

* *

(swap) -->

[2, 3, 17, 1 | 20, 21]

(sift down)-->

[17, 3, 2, 1 | 20, 21]

* *

(swap) -->

[1, 3, 2 | 17, 20, 21]

(sift down)-->

[3, 1, 2 | 17, 20, 21]

* *

(swap) -->

[1, 2 | 3, 17, 20, 21]

(Done!)

以上便是 heapsort 演算法的簡單流程,是不是和 selection sort 非常相似呢!

效能

| Complexity | |

|---|---|

| Worst | $O(n \log n) $ |

| Best | $O(n \log n) $ |

| Average | $O(n \log n) $ |

| Worst space | $O(1) $ auxiliary |

Heapsort 最佳、最差、平均的時間複雜度皆為 $O(n \log n) $,同樣分為兩部分簡單解釋。

Build heap (heapify)

建立一個 binary heap 有兩種方法,一種是一個個元素慢慢加入 heap 來建立;另一種則是給定隨意的序列,再透過 heapify 演算法修正序列為有效的 heap。一般來說 heapsort 常用實作後者。

Heapify 是指將序列修正至符合 heap ordering 的序列。給定一個元素,假定其為非法的 heap order,而該元素之後的 subtree 視為符合 heap ordering property。欲修正這個在錯誤位置的元素,必須透過與其 children node 置換往下篩,這個往下篩的過程就稱為 sift down,在實作一節會詳細解釋,這邊只要知道 sift down 會不斷將該元素與其 child node 比較,若不符合 heap order 則與 child node 置換,並繼續疊代每一個 level。所以 sift down 的時間複雜度為 $O(\lceil {\log_2(n)} \rceil) = O(\log n) $, $n $ 為陣列元素個數。

Heapify 從最末個元素開始反向疊代,每個元素都呼叫 sift_down 調整 heap 符合 heap ordering。總共要做 $n $ 次 sift_down 操作,但由於最後一層所以 leaf 已符合 heap order(因為沒有 child node),我們的迴圈可以跳過所有 leaf node 直接從非 leaf node 開始,因此複雜度為

$$\lfloor n / 2 \rfloor \cdot O(\log n) = O(n \log n)$$

實際上,build heap 步驟的複雜度可達到 $O(n) $,可以看看 UMD 演算法課程 Lecture note 的分析。

Sorting (sift down)

講完了 heapify,就換到排序部分,所謂的排序其實就是利用 max-heap(或 min-heap)的最大值(最小值)會在首個元素的特性,與最後一個元素置換,完成排序,並將剩餘的部分透過 sift down 修正符合 heap order。所以總共需要做 $n $ 次 sift down,複雜度為 $O(n \log n) $。

Sum up

綜合這兩部分,可以看出 Sorting part 對複雜度有決定性影響,最佳複雜度為 $O(n \log n) $。

實作

Heapsort 的實作相對簡單,只需要不斷呼叫 heap 內部的 sift_down 方法就可以完成排序。整個演算法架構如下:

#![allow(unused)] fn main() { pub fn heapsort(arr: &mut [i32]) { // -- Heapify part -- // This procedure would build a valid max-heap. // (or min-heap for sorting descendantly) let end = arr.len(); for start in (0..end / 2).rev() { // 1 sift_down(arr, start, end - 1); } // -- Sorting part -- // Iteratively sift down unsorted part (the heap). for end in (1..arr.len()).rev() { // 2 arr.swap(end, 0); // 3 sift_down(arr, 0, end - 1); // 4 } } }

- 這部分是 heapify,從最小 non-leaf node 開始(

end/ 2),修正序列至滿足 heap order,再反向疊代做 heapify。 - 這部分負責排序,每次疊代都將排序 heap 的 root 元素,步驟如 3 - 4:

- 不斷將 max-heap 中最大值(在 root 上)與 heap 最後一個元素

end置換, - 並利用

sift_down將序列修正至 max-heap 資料結構,依照定義,此時 unsorted pile 首個元素成為 max-heap root,是最大值。

Heapsort 全靠 sift_down 神救援,那 sift_down 到底有什麼神奇魔力,一探究竟吧!

#![allow(unused)] fn main() { fn sift_down(arr: &mut [i32], start: usize, end: usize) { let mut root = start; loop { let mut child = root * 2 + 1; // Get the left child // 1 if child > end { break; } if child + 1 <= end && arr[child] < arr[child + 1] { // 2 // Right child exists and is greater. child += 1; } if arr[root] < arr[child] { // 3 // If child is greater than root, swap'em! arr.swap(root, child); root = child; } else { break; } } } }

sift_down 的功能是將 node 往下移。通常用在 heap 刪除或取代 node 時,將序列修正為有效的 heap。 這裡實作的版本有三個參數:

arr:欲修正為符合 heap 定義的序列。start:欲往下移動的 node index,可視為需要被修正的元素。end:此 node 以內(包含)的序列都會被修正為有效的 heap。

sift_down 有些假設條件:從 start index 出發的子樹,除了 start 本身以外,其他皆符合 heap ordering。

再來看看 sift_down 實作內容,loop 中幹的活就是不斷將 start index 上的元素與其子樹比較,若不符合 heap ordering,則兩者置換。

- 是否有子結點:依照 binary heap 的定義找出 root 的左子樹(left substree),若左子樹的 index

child比end還大,表示沒有 heap 沒有子結點,停止疊代。 - 檢查右子樹值較大:若 root 下有右子樹且較大,我們會標記右子樹,並在下一步對右子樹進行處理。

- 置換:若

root元素比child的元素小,則置換兩者,並將child設置為下個疊代的root,繼續檢查最初的start元素是否滿足 heap ordering。

以上就是簡單的 sift_down 實作,也是整個 heapsort 的精髓。

參考資料

- Wiki: Heap

- Wiki: Heapsort

- CMSC 351 Algorithms, Fall, 2011, University of Maryland.

- Sorting GIF by RolandH CC BY-SA-3.0 via Wikimedia Commons.

快速排序 Quicksort

Quicksort 是一個非常熱門且應用廣泛的排序法,相對簡單的實作就可達到 $O(n \log n) $ 的平均時間複雜度。雖然最差時間複雜度與 bubble sort 同為 $O(n^2) $,但這種情形非常少見。簡單的最佳化實作下,Quicksort 僅需 $O(\log n) $ 的額外儲存空間,比它的競爭對手 mergesort 來得節省。非常適合運用在真實世界中的排序法。

Quicksort 基本特性如下:

- 實作簡單,速度快。

- 不穩定排序:排序後,相同鍵值的元素相對位置可能改變。

- 非原地排序:除了資料本身,仍需額外花費儲存空間來排序。

- 分治演算法:將主問題化作數個子問題,各個擊破。

步驟

Quicksort 是一個分治演算法(divide-and-conquer),不斷遞迴下列三個步驟:

- 選擇 Pivot:在序列中任意選擇一個元素,稱為 Pivot。

- 分割序列:將序列重新排序,分為兩部分,比 pivot 小 的元素置換到 pivot 之前,比 pivot 大的元素置換到 pivot 之後,而 pivot 本身會座落在它最終的正確位置。

- 遞迴:分別將「比 pivot 小」及「比 pivot 大」兩部分重複上述步驟,直到新序列的長度小於等於 1,無法繼續分割為止,此時排序完成。

Lomuto partition scheme

為了達成上述條件,Quicksort 有許多不同的分割序列實作方案(partition scheme),其中以 Lomuto partition 最易理解,常被做為教材。

- 以序列最後一個元素當做 pivot。

- 利用兩個指標

ij,其中j從頭疊代整個序列- 若有序列第 j 個元素小於 pivot,則與第 i 個元素置換。

- 第 i 個元素已落在小於 pivot 的範圍,將 i 指標往後移一個,處理下個元素。

- 疊代完成後,小於 pivot 的元素全都置換至序列前端,此時將 pivot 與第 i 個元素置換,pivot 會剛好在最終正確位置上(符合不等式)。

ASCII 畫出來的分割圖如下:

[ values <= pivot | values > pivot | not checked yet | pivot ]

low i i+1 j-1 j high-1 high

arr[low...i]包含所有小於等於 pivot 的元素。arr[i+1...j-1]包含所有大於 pivot 的元素。arr[j...high-1]包含所有尚未疊代的元素。arr[high]pivot 本身。

說明

以 Lomuto partition scheme 為例,使用 ASCII diagram 解釋。

給定一個序列,並選擇最後一個元素作為 pivot,i j 指標則在第一個元素位置。

* -> pivot

[17, 20, 2, 1, 3, 21, 8]

i

j

第 j 個元素 17 大於 pivot 8,不置換。

17 > 8, no swap

* -> pivot

[17| 20, 2, 1, 3, 21, 8]

i

j

第 j 個元素 20 大於 pivot 8,不置換。

20 > 8, no swap

* -> pivot

[17, 20| 2, 1, 3, 21, 8]

i

j

第 j 個元素 2 小於 pivot 8,置換 i j。i 往後一個位置。

2 <= 8,

swap i, j

* -> pivot

[2, 20, 17| 1, 3, 21, 8]

i->i

j

第 j 個元素 1 小於 pivot 8,置換 i j。i 往後一個位置。

1 <= 8

swap i, j

* -> pivot

[2, 1, 17, 20| 3, 21, 8]

i->i

j

第 j 個元素 3 小於 pivot 8,置換 i j。i 往後一個位置。

3 <= 8

swap i, j

* -> pivot

[2, 1, 3, 20, 17| 21, 8]

i->i

j

第 j 個元素 21 大於 pivot 8,不置換。

21 > 8, no swap

* -> pivot

[2, 1, 3, 20, 17, 21| 8]

i

j

最後,將 pivot 與第 i 個元素置換,此時 pivot 已在最終位置上,前面的元素皆小於等於 8,其後的元素皆大於 8。

swap pivot, i

i <-> * -> pivot

[2, 1, 3, 8, 17, 21, 20]

這樣就完成一次的 partition 了!

之後再遞迴分割 subarray 即可完成 Quicksort。

[2, 1, 3, 8, 17, 21, 20]

# # * *

| | | |

------- ---------

quicksort quicksort

效能

| Complexity | |

|---|---|

| Worst | $O(n^2) $ |

| Best | $O(n \log n) $ |

| Average | $O(n \log n) $ |

| Worst space | $O(\log n) $ or $O(n) $ auxiliary |

Time complexity

Quicksort 僅有「選擇 Pivot」與「分割序列」兩步驟,不同的實作的效能各異,也影響 Quicksort 的時間複雜度。

最差情況

最差的分割序列狀況發生在挑選的 pivot 總是最大或最小值(或在 Lomuto partition 下,所有元素值都一樣)。由於 Lomuto 總是選擇最後一個元素作為 pivot,這種情形好發於已排序或接近排序完成的資料上。

而當每次的 partition 都是最不平衡的分割序列,就會產生最差時間複雜度的狀況。遞迴在序列長度等於 1 時停止,因此整個排序法的 call stack 需要 $n - 1 $ 的嵌套遞迴呼叫(nested call);而第 $i $ 次分割會執行 $n - i $ 次基本操作( $O(n) $),所以總共需執行

$$\sum_{i = 0}^n (n - i) = n^2 - \frac{n(n + 1)}{2}$$

次基本操作,最差時間複雜度為 $O(n^2) $。

最佳情況

既然最差情況發生在 pivot 總選到最大或最小值,反之,最佳情況則發生在每次 pivot 都可以順利選到序列的中位數(median),如此一來,每次遞迴分割的序列長度都會減半( $n / 2 $),call stack 的嵌套遞迴總共需要 $2 \log_2{n} $ 次,序列的長度就會減至 1,而每次分割同樣有 $O(n) $ 的複雜度,因此最佳情況為:

$$O(n \cdot 2 \log_2{n}) = O(n \log n)$$

Space complexity

Quicksort 的空間複雜度取決於實作細節,由於分割序列步驟需 $O(1) $ 的空間複雜度,因此僅需分析遞迴式會在 call stack 產生多少 stack frame 即可。

前面提及,最 naïve 的 Lomuto partition 最糟糕的情形下,會產生 $n - 1 $ 個嵌套遞迴,也就是需額外使用 $O(n) $ 的空間儲存 call stack frame,但只要 compiler 有支援尾端呼叫最佳化(tail-call optimization,TCO),Quicksort 很容易最佳化至 $O(\log n) $。

實作

Quicksort 實作主要分為兩部分:遞迴,以及分割序列(partition)。

Recursion

遞迴函式本身實作非常簡單,分別將小於 pivot 與大於 pivot 兩部分遞迴呼叫自身即可。

#![allow(unused)] fn main() { /// Recursion helper fn quicksort_helper(arr: &mut [i32], lo: isize, hi: isize) { if lo <= hi { // 1 let pivot = partition(arr, lo, hi); // 2 quicksort_helper(arr, lo, pivot - 1); // 3 quicksort_helper(arr, pivot + 1, hi); // 4 } } }

- 利用

lo與hi兩個指標決定每次的遞迴範圍,並在lo大於hi時停止遞迴,避免重複分割序列。 - 分割序列步驟,回傳該序列範圍內 pivot 的 index。

- 遞迴小於 pivot 的部分。

- 遞迴大於 pivot 的部分。

這邊比較特別的是,

lo和hi兩個指標的型別為isize,因為當 pivot 可能為 0,在第三步驟 - 1 時會產生型別錯誤,故為之。有任何更好的寫法歡迎提供!

由於外部不需知道排序法實作細節,我們將函式命名為 quicksort_helper ,對外再多封裝一層主函式 quicksort_lomuto,實作如下:

#![allow(unused)] fn main() { pub fn quicksort_lomuto(arr: &mut [i32]) { let hi = arr.len() as isize - 1; quicksort_helper(arr, 0, hi); } }

Partitioning

一般來說,分割序列的實作有下列兩個步驟:

- 選擇 pivot

- 遍歷序列置換元素

我們以 Lomuto scheme 實作 partition。

#![allow(unused)] fn main() { fn partition(arr: &mut [i32], lo: isize, hi: isize) -> isize { // -- Determine the pivot -- // In Lomuto parition scheme, // the latest element is always chosen as the pivot. let pivot = arr[hi as usize]; // 1 let mut i = lo; // -- Swap elements -- for j in lo..hi { // 2 if arr[j as usize] < pivot { arr.swap(i as usize, j as usize); i += 1; // 3 } } // Swap pivot to the middle of two piles. arr.swap(i as usize, hi as usize); // 4 i // Return the final index of the pivot } }

- Lomuto scheme 選擇 pivot 的方式很直接,就是選擇最後一個元素。

- 利用

i、j兩個指標疊代指定的序列範圍,若第 j 個值小於 pivot 時,則於第 i 個元素置換。 i指標加一,繼續處理下個元素。- 最後置換第 i 個元素於 pivot,此時 pivot 已落在最終正確的位置。

最佳化與變形

Quicksort 有數個方向可以探討最佳化:

降低額外空間複雜度

前述提到最佳情形下(每次 pivot 都選到中位數),僅需 $\log n $ 個嵌套遞迴,額外空間複雜度僅需 $O(\log n) $。 倘若編譯器有實作 尾端呼叫最佳化,Quicksort 可以達到 $O(\log n) $ 對數級別的額外空間使用。

實作尾端呼叫最佳化的思路很簡單,「先遞迴較少元素的部分,再利用 tall-call 遞迴另一部分」,如此以來,較多元素的遞迴則會直接被編譯器展開,消去遞迴時需要的 call stack 空間。剩下較少元素的部分,則與最佳情形相同,最多僅需 $\log n $ 次嵌套遞迴。

簡單實作如下:

#![allow(unused)] fn main() { fn quicksort_helper_optimized(arr: &mut [i32], lo: isize, hi: isize) { if lo <= hi { let pivot = partition(arr, lo, hi); if pivot - lo < hi - pivot { // 1 quicksort_helper_optimized(arr, lo, pivot - 1); quicksort_helper_optimized(arr, pivot + 1, hi); // 2 } else { quicksort_helper_optimized(arr, pivot + 1, hi); quicksort_helper_optimized(arr, lo, pivot - 1); // 3 } } } }

- 說穿了就只有這個判斷式,決定哪部分該先遞迴而已。

- 這是一個尾端呼叫,會展開。

- 這也是一個尾端呼叫。

實際上,截至 2018.2,Rust Core Team 決定暫緩 TCO 的實作,目前 Rust 並沒有支援 TCO。但我們還是可以手動實作 TCO,減少 call stack。

我們先把原始的 lomuto partition 實作改成手動 TCO 版本。利用 while loop,將 lo 替換成下一個遞迴的引數,減少部分的 call stack。

- fn quicksort_helper(arr: &mut [i32], lo: isize, hi: isize) {

+ fn quicksort_helper_manual_tco(arr: &mut [i32], mut lo: isize, mut hi: isize) {

- if lo <= hi {

+ while lo < hi {

let pivot = partition(arr, lo, hi);

- quicksort_helper(arr, lo, pivot - 1);

- quicksort_helper(arr, pivot + 1, hi);

+ quicksort_helper_manual_tco(arr, lo, pivot - 1);

+ lo = pivot + 1;

}

}

再來,選擇性遞迴較小的部分。Iterative 版本的尾端呼叫消除(tail-call eliminate)就做完了!

#![allow(unused)] fn main() { fn quicksort_helper_manual_tco(arr: &mut [i32], mut lo: isize, mut hi: isize) { while lo < hi { let pivot = partition(arr, lo, hi); if pivot - lo < hi - pivot { quicksort_helper_manual_tco(arr, lo, pivot - 1); lo = pivot + 1; } else { quicksort_helper_manual_tco(arr, pivot + 1, hi); hi = pivot - 1; } } } }

選擇 Pivot 的方法

選擇 pivot 的方法大致上有以下幾種:

- 總是選擇最後一個元素。

- 總是選擇第一個元素。

- 選擇特定位置(如中位數)的元素。

- 隨機選擇任意元素。

選擇第一個或最後一個元素會印序列已經接近排序完成或相反排序,造成 $O(n^2) $ 最壞的時間複雜度。隨機或選擇特定位置的方法較能避免這種情況,但實作上較困難。

除了選擇 pivot 的方法,近幾年來多 pivot(multi-pivot)Quicksort 也愈趨流行,可以減少 20% 的元素置換。相關的討論與證明可以參考這篇文章。

對付重複的元素

若輸入序列有許多重複的元素,使用原本 Lomuto scheme 實作的 Quicksort 仍然會比較置換等於 pivot 的所有元素。3-way partition scheme 就是將序列多分出「等於 pivot」部分,減少重複置換相等元素的排序法。

[ values < pivot | values == pivot | value > pivot ]

通常是使用著名的 Dutch national flag algorithm 來解決這個問題。實作上和 Lomuto 非常類似。

#![allow(unused)] fn main() { fn partition(arr: &mut [i32], lo: isize, hi: isize) -> (isize, isize) { let pivot = arr[hi as usize]; let mut i = lo; // smaller let mut j = lo; // equal let mut k = hi; // large while j <= k { if arr[j as usize] < pivot { arr.swap(i as usize, j as usize); i += 1; j += 1; } else if arr[j as usize] > pivot { arr.swap(k as usize, j as usize); k -= 1; } else { // No swap when identicial. j += 1; } } // Return smaller and larger pointer to avoid iterate duplicate elements. (i, k) } }

選擇不同的分割方案

不同的分割方案有著不同的應用場景,如上述的 3-way scheme 就適合重複元素多的序列。這裡再多介紹另一個常見的分割實作方案 Hoare partition,是 Quicksort 發明這 Hoare 自己提出的分割法,Rust 實作演算法如下:

#![allow(unused)] fn main() { fn partition(arr: &mut [i32], lo: usize, hi: usize) -> usize { let pivot = arr[lo]; let mut i = lo; let mut j = hi; loop { // Find element >= pivot from leftmost element. while arr[i] < pivot { // 1 i += 1; } // Find element <= pivot from rightmost element. while arr[j] > pivot { // 2 j -= 1; } if i >= j { return j; } // Two elements are misplaced, swap them. arr.swap(i, j); // 3 i += 1; j -= 1; } } }

- 從最左邊開始找比 pivot 大或相等的元素。

- 從最右邊開始找比 pivot 小或相等的元素。

- 若找到這兩個元素,置換之,以符合小於 pivot 在前,大於 pivot 在後的分割準則。

參考資料

- Wiki: Quicksort

- Algorithms, 4th Edition by R. Sedgewick and K. Wayne

- GeeksForGeeks: QuickSort

- Swift Algorithm Club: Quicksort

合併排序 Mergesort

Mergesort 是一個泛用且高效穩定的排序法,最佳與最差時間複雜都是 $O(n \log n) $。Mergesort 可謂著名「Divide and Conquer」手法的經典案例,先將序列分成更小的子序列(Divide),一個個排序後(Conquer),再合併已排序的子序列(Combine)。

- 高效穩定:最佳、平均,與最差時間複雜度皆為 $O(n \log n) $。

- 穩定排序:相同鍵值的元素,排序後相對位置不改變。

- 非原地排序:除了資料本身,仍需額外花費儲存空間來排序。

- 分治演算法:將主問題化作數個子問題,各個擊破。

步驟

Mergesort 演算法分為以下步驟:

- Divide:將含有 n 個元素的序列分割成含有 n / 2 個子序列。

- Conquer:排序分割後的兩個子序列。

- Combine:合併排序完成的兩子序列,成為一個排好序的序列。

其中,Conquer 步驟中的「排序」可以不斷遞迴 Mergesort 自身,因此需要停止遞迴的條件(base case),我們將條件設定為「子序列的長度小於 2」,因為長度為 1 的序列可視為已完成排序。

將 Mergesort 視覺化排序如下:

說明

以 ASCII diagram 圖解 Mergesort。

先將原始序列分割成數個長度為一的子序列。

Split array into length 1 subarray.

[8, 7, 1, 2, 4, 6, 5, 3]

|

[8, 7, 1, 2] | [4, 6, 5, 3]

|

[8, 7] [1, 2] | [4, 6] [5, 3]

|

[8] [7] [1] [2] | [4] [6] [5] [3]

V

split

再將子序列依序合併成一個排好序的大序列。

Recursively merge subarray respecting the order.

Merge

|

[8] [7] [1] [2] | [4] [6] [5] [3]

|

[7, 8] [1, 2] | [4, 6] [3, 5]

|

[1, 2, 7, 8] | [3, 4, 5, 6]

V

[1, 2, 3, 4, 5, 6, 7, 8]

效能

| Complexity | |

|---|---|

| Worst | $O(n \log n) $ |

| Best | $O(n \log n) $ |

| Average | $O(n \log n) $ |

| Worst space | $O(n) $ auxiliary |

Time Complexity

透過遞迴關係式,很容易計算 Mergesort 的時間複雜度。假設排序長度為 $n $ 的序列最多需要 $T(n) $ 時間。可以觀察到,如果序列只有一個元素,Mergesort 僅需要常數時間就可以完成排序,寫成 $T(n) = 1 $。

如果 $n > 2 $,Mergesort 會將序列分為 $\lceil \frac{n}{2} \rceil $ 部分,以及 $\lfloor \frac{n}{2} \rfloor $ 部分。我們可以將排序前者寫成 $T(\lceil \frac{n}{2} \rceil) $,而後者花費時間為 $ T(\lfloor \frac{n}{2} \rfloor) $。

最後,合併兩個子序列僅需 $n $ 個操作。可得下列遞迴關係式。

(為了方便計算,把 floor 和 ceil 捨去)

$$ T(n) = \begin{cases} 1 & \text{if } n = 1, \\ 2T(\frac{n}{2}) + n & \text{otherwise.} \end{cases} $$

根據 Master Theorem,可得複雜度為 $O(n \log n) $。

Space Complexity

Mergesort 的缺點之一就是在合併子序列時,需要額外的空間依序插入排序資料;若是遞迴版本的 Mergesort 還需額外加上遞迴花費的 call stack 空間,因此額外空間複雜度為 $O(n) + O(\log n) = O(n) $(以陣列實作)。

實作

一般來說,Divide and Conquer 有兩種設計、解決問題的技巧:Top-down(自上而下)與 Buttom-up(自下而上)。前者是先對問題有整體的輪廓概念,再逐步針對細節一一處理;後者則是先準備每個問題需要的基礎步驟與元件,再將這些步驟結合,解決整體的問題。

Mergesort 的實作分為兩部分:

mergesort主程式:對外的介面,負責分割序列。對應 Divide 功能。merge:合併子序列,對應到 Conquer 與 Combine 功能。

先來看看如何分割序列。

Top-down split

自上而下的解法會不斷以類似 binary search 的方式找中點,進而分割序列。

#![allow(unused)] fn main() { pub fn mergesort(arr: &mut [i32]) { let mid = arr.len() / 2; if mid == 0 { // 1 return; } mergesort(&mut arr[..mid]); // 2 mergesort(&mut arr[mid..]); // Create an array to store intermediate result. let mut ret = arr.to_vec(); // 3 // Merge the two piles. merge(&arr[..mid], &arr[mid..], &mut ret[..]); // 4 // Copy back the result back to original array. arr.copy_from_slice(&ret); // 5 } }

- 設定遞迴的終止條件(base case),middle index 為 0 表示長度不大於 1。

- 利用 Rust 的 Range Operator,可快速分割兩個

slice。 - 建立一個

Vec儲存排序結果。 - 將兩個

slice合併排序至retvector 中。 - 將

ret的結果複製到原始arr中,使回傳值保有相同起始位址。

Buttom-up split

自下而上的解法則是預定好最小的子序列長度,直接使用 for 迴圈從頭開始逐一擊破。

#![allow(unused)] fn main() { pub fn mergesort_bottom_up(arr: &mut [i32]) { let mut width = 1; // 1 // Create an array to store intermediate result. let mut ret = arr.to_vec(); // 2 let len = arr.len(); while width < len { let mut i = 0; while i < len { // Check to avoid upper bound and middle index out of bound. let upper = ::std::cmp::min(i + 2 * width, len); // 3 let mid = ::std::cmp::min(i + width, len); merge(&arr[i..mid], &arr[mid..upper], &mut ret[i..upper]); // Copy the merged result back to original array. arr[i..upper].copy_from_slice(&ret[i..upper]); // 4 // Increase start index to merge next two subsequences. i += 2 * width; // 5 } width *= 2; // 6 } } }

- 設定最小的子序列長度,這個長度以下的子序列皆視為已排序。

- 建立一個

Vec儲存排序結果。 - 取最小值,避免下標超出邊界,並且維持除了最後一組,其他子序列長度恆為

width。 - 複製這部分排序結果

ret到原始的arr中。 - 繼續下兩個子序列的合併步驟。

- 將下個疊代的子序列長度加倍,繼續合併。

The merge part

無論是 Top-down 還是 Buttom-up 版本的解法,皆免不了 merge 這個共同步驟,將子序列合併為較大的序列。

#![allow(unused)] fn main() { fn merge(arr1: &[i32], arr2: &[i32], ret: &mut [i32]) { let mut left = 0; // Head of left pile. // 1 let mut right = 0; // Head of right pile. let mut index = 0; // Compare element and insert back to result array. while left < arr1.len() && right < arr2.len() { // 2 if arr1[left] <= arr2[right] { // 3 ret[index] = arr1[left]; index += 1; left += 1; } else { ret[index] = arr2[right]; index += 1; right += 1; } } // Copy the reset elements to returned array. // `memcpy` may be more performant than for-loop assignment. if left < arr1.len() { // 4 ret[index..].copy_from_slice(&arr1[left..]); } if right < arr2.len() { ret[index..].copy_from_slice(&arr2[right..]); } } }

- 建立三個指標,分別給

arr1、arr2與回傳陣列ret使用。 - 這部分依序比較兩個子序列,排序較小者先進入回傳

ret。直到其中一序列所有元素都進入ret就停止。 - 這邊判斷使用

<=小於等於確保排序穩定(相同鍵值順序不換)。 - 將剩餘未進入

ret的元素,依序複製到ret中。

slice.copy_from_slice底層使用 C 的memcpy,比起 for-loop 一個個賦值,直接複製整塊記憶體比較快了。

變形

Timsort

在真實世界資料中,早有許多部分排序的分區(natural run),倘若跳過排序這些分區的步驟,就可減少許多不必要的操作,Timsort 就是為了完全利用榨乾這些分區的混合排序法。

參考資料

- Wiki: Merge sort

- CMSC 351 Algorithms, Fall, 2011, University of Maryland.

- Sorting GIF was created By CobaltBlue CC BY-SA 2.5 via Wikimedia Commons.

計數排序 Counting sort

Counting sort 是一個特殊的整數排序法,被視為 Bucket sort 的特例。原理是在已知整數範圍內,計算每個鍵值出現次數,並用額外的陣列保存(Count array)。最後將 Count array 的元素值作為排序資料的新 index。

Counting sort 基本特性如下:

- 非原地排序:額外花費較大量、非固定的空間來排序。

- 穩定排序:相同鍵值的元素,排序後相對位置不改變。

- 整數排序:以整數作為排序的鍵值。

- 分配式排序:不透過兩兩比較,而是分析鍵值分佈來排序。特定情況下可達線性執行時間。

- 線型執行時間:當輸入資料量 n 與已知範圍上下界之差值相近,執行時間接近線型(O(n))

- 預期分佈:預期輸入資料是落在已知範圍內的整數(例如 0 到 k)。

- 適用範圍:僅適用於小範圍整數(額外空間需求大)。

步驟

- Count occurrence:計算每個 key 的出現次數。

- Prefix sum as start index:計算前綴和(Prefix sum),並作為該元素的 start index。

- Copy output:利用步驟二的前綴和,遍歷輸入資料,取得元素排序後的索引。

說明

這裡有資料需要透過正整數的 key 來排序。key 的範圍在 0 - 9 之間,格式為 (key, value)。

Input: (1, A) (5, B) (8, C) (2, D) (2, E) (9, F)

1. Count occurrence:首先,先計算每個 key 的出現頻率,儲存在額外的 count array 中。

Key : 0 1 2 3 4 5 6 7 8 9

Count: 0 1 2 0 0 1 0 0 1 1

2. Prefix sum as start index:再計算 prefix sum,也就是將當前 index 前累計的 key 數量加總。例如 key 5 的 prefix sum 1 + 2 = 3。

這裡的 prefix sum 等同於每筆資料排序後的位置(index)。例如排序後,8 位於陣列第四位。

Key : 0 1 2 3 4 5 6 7 8 9

Prefix Sum: 0 0 1 3 3 3 4 4 4 5

3. Copy output:透過 key 與 prefix sum 的映射關係,找到原始資料對應的位置。

實作上,每筆資料找到對應的 start index(prefix sum) 後,要將該 index 之值 +1,使得重複的元素可取得正確的 index offset(對唯一的 key 沒有影響)。

(1, A)

--> prefix sum 為 0,寫入 array[0],並將 prefix sum + 1

+--------+--------+--------+--------+--------+--------+

| (1, A) | | | | | |

+--------+--------+--------+--------+--------+--------+

(5, B)

--> prefix sum 為 3,寫入 array[3],並將 prefix sum + 1

+--------+--------+--------+--------+--------+--------+

| (1, A) | | | (5, B) | | |

+--------+--------+--------+--------+--------+--------+

(8, C)

--> prefix sum 為 4,寫入 array[4],並將 prefix sum + 1

+--------+--------+--------+--------+--------+--------+

| (1, A) | | | (5, B) | (8, C) | |

+--------+--------+--------+--------+--------+--------+

(2, D)

--> prefix sum 為 1,寫入 array[1],並將 prefix sum + 1

+--------+--------+--------+--------+--------+--------+

| (1, A) | (2, D) | | (5, B) | (8, C) | |

+--------+--------+--------+--------+--------+--------+

(2, E)

--> prefix sum 為 2(前一步驟 + 1),寫入 array[2],並將 prefix sum + 1

+--------+--------+--------+--------+--------+--------+

| (1, A) | (2, D) | (2, E) | (5, B) | (8, C) | |

+--------+--------+--------+--------+--------+--------+

(9, F)

--> prefix sum 為 5,寫入 array[5],並將 prefix sum + 1

+--------+--------+--------+--------+--------+--------+

| (1, A) | (2, D) | (2, E) | (5, B) | (8, C) | (9, F) |

+--------+--------+--------+--------+--------+--------+

這樣就完成排序了。此外,觀察 (2, D) 與 (2, E) 排序前後的位置,會發現 counting sort 是個實實在在的穩定排序,很棒。

效能

| Complexity | |

|---|---|

| Worst | $O(n + k) $ |

| Best | $O(n + k) $ |

| Average | $O(n + k) $ |

| Worst space | $O(n + k) $ auxiliary |

k 為資料已知範圍上下界之差。

Time Complexity

Counting sort 沒有用到任何遞迴,可以直觀地分析複雜度。在步驟一,建立 count array 與步驟三輸出排序結果,都需要遍歷 $n $ 個輸入的資料,因此複雜度為 $O(n) $;步驟二計算 prefix sum,以及 count array 自身的初始化則需執行 $k + 1 $ 次(給定的資料範圍),這部分的複雜度為 $O(k) $。由於 $n $ 與 $k $ 的權重會因輸入資料及實作的不同而有所改變,我們無法捨棄任何一個因子,可得知 counting sort 的複雜度為 $O(n + k) $。

Space complexity

Counting sort 並非 in-place sort,排序後的結果會另外輸出為新的記憶體空間,因此 $O(n) $ 的額外(auxiliary)空間複雜度絕對免不了。再加上需要長度為 $k $ 的 count array 保存每個 key 的出現次數,因此需再加上 $O(k) $。除了原始的輸入 array,總共需花費 $O(n + k) $ 的額外空間複雜度。

如果欲排序資料就是整數鍵值自身,可以將「計算前綴和」與「複製輸出」兩步驟最佳化,直接覆寫原始陣列,額外空間複雜度會下降至 $O(k) $,但也因此成為不穩定排序法。

實作

由於 Counting sort 屬於分布式排序(Distribution sort),這裡使用泛型,以彰顯分布式排序的特色。

Function Signature

首先,我們先看函式如何宣告(function signature)。

#![allow(unused)] fn main() { pub fn counting_sort<F, T>(arr: &mut [T], min: usize, max: usize, key: F) where F: Fn(&T) -> usize, T: Clone, }

這裡使用了四個參數:

arr:待排序陣列。min、max:整數排序的上下界。key:由於資料不一定是整數,需要一個 function 從資料擷取鍵值做排序。

另外,也使用兩個泛型型別:

F:keyextactor 的型別,回傳的usize必須落在[min, max)之間。T:陣列元素的型別,實作Clone是由於 Counting sort 需要將 output 再複製回原本的參數arr上,達成「偽」原地排序。

Prefix Sums Array

再來,了解如何建立一個元素出現次數的陣列。

#![allow(unused)] fn main() { fn counting_sort() { // ... let mut prefix_sums = { // 1. Initialize the count array with default value 0. let len = max - min; let mut count_arr = Vec::with_capacity(len); count_arr.resize(len, 0); // 2. Scan elements to collect counts. for value in arr.iter() { count_arr[key(value)] += 1; } // 3. Calculate prefix sum. count_arr.into_iter().scan(0, |state, x| { *state += x; Some(*state - x) }).collect::<Vec<usize>>() }; // ... } }

- 建立一個長度為上下界之差的 count array。注意,這裡使用了

Vec.resize,因為 Rust initialize 空的Vec時並不會插入 0 或其他預設值。 - 遍歷整個輸入資料,利用

keyfunction 取出每筆資料的鍵值,出現一次就 +1。 - 利用 Iterator 上的

scanmethod 計算每個鍵值的 prefix sum。需要注意的是,每個元素對應的 prefix sum 不包含自身,例如 key 3 的計算結果就是 key 1 與 key 2 的出現總次數,如此一來,prefix sum 才會直接對應到排序後的位置。

Prefix Sums as Start Index

最後一步就是將 prefix sum 當作每個 element 的正確位置,把資料重頭排序。

#![allow(unused)] fn main() { fn counting_sort() { // ... for value in arr.to_vec().iter() { // 1 let index = key(value); arr[prefix_sums[index]] = value.clone(); // 2 prefix_sums[index] += 1; // 3 } } }

- 將輸入資料透過

to_vec複製起來疊代,需要複製arr是因為之後要直接在arr插入新值,需要另一份原始輸入的拷貝。 - 利用

key擷取鍵值後,把資料複製給arra上對應prefix_sums[index]的位置。 - 將該

prefix_sums[index]的值加一,以便元素重複時,可以正常複製到下一個位置。

完成了!這裡再貼一次完整的程式碼。

#![allow(unused)] fn main() { pub fn counting_sort<F, T>(arr: &mut [T], min: usize, max: usize, key: F) where F: Fn(&T) -> usize, T: Clone, { let mut prefix_sums = { // 1. Initialize the count array with default value 0. let len = max - min; let mut count_arr = Vec::with_capacity(len); count_arr.resize(len, 0); // 2. Scan elements to collect counts. for value in arr.iter() { count_arr[key(value)] += 1; } // 3. Calculate prefix sum. count_arr.into_iter().scan(0, |state, x| { *state += x; Some(*state - x) }).collect::<Vec<usize>>() }; // 4. Use prefix sum as index position of output element. for value in arr.to_vec().iter() { let index = key(value); arr[prefix_sums[index]] = value.clone(); prefix_sums[index] += 1; } } }

參考資料

桶排序 Bucket sort

Bucket sort,是一個非比較排序。原理是建立一些桶子,每個桶子對應一資料區間,在將待排序資料分配到不同的桶中,桶子內部各自排序。由於並非比較排序,使用 Bucket sort 需要事先知道資料的範圍與分佈,才能決定桶子對應的區間。

Bucket sort 基本特性如下:

- 又稱 bin sort。

- 穩定排序:相同鍵值的元素,排序後相對位置不改變。

- 分配式排序:不透過兩兩比較,而是分析鍵值分佈來排序。特定情況下可達線性執行時間。

- 預期分佈:資料為均勻分佈。

步驟

假設要排序 $n $ 個元素的陣列,這些元素的值平均散落在某個已知的預期範圍內,例如 1 到 100。

- Create buckets:建立 $k $ 個桶子(bucket)的陣列。每個桶子對應預期範圍的某區間,如第一個桶子放 1 到 10,第二個放 11 到 20。

- Scatter:將每個元素依照該值放入對應的桶子中。

- Inner sort:排序所有非空的桶子。

- Gather:依序走訪所有桶子,將桶內的元素放回原本的陣列中。

說明

以下用 ASCII diagram 視覺化解釋:

這裡有一些整數,落在 1 至 100 之間。我們有 $n = 10 $ 的陣列要排序。

Original array

+-------------------------------------------------+

| 6 | 28 | 96 | 14 | 74 | 37 | 9 | 71 | 91 | 36 |

+-------------------------------------------------+

1. Create buckets:建立一定數量的桶子,這裡我們建立與原始陣列相同數量的桶子(10)。每個桶子對應 $n - 1 * 10 $ 到 $n * 10 $ 的區間。

Bucket array

+-------------------------------------------------+

| | | | | | | | | | |

+-------------------------------------------------+

^ ^

| |

| |

| holds values in range 11 to 20

holds values in range 1 to 10

2. Scatter:將原始陣列中的元素,放入對應的桶中。

Bucket array

6,9 14 28 37,36 74,71 96,91

| | | | | |

+-v----v----v----v-------------------v---------v--+

| | | | | | | | | | |

+-------------------------------------------------+

3. Inner sort:排序所有非空桶子中的元素,桶內排序可用任意排序法,通常選用「insertion sort」,可確保排序穩定性,並降低額外開銷。

Bucket array

sort sort sort sort sort sort

--- -- -- ----- ----- -----

6,9 14 28 36,37 71,74 91,96

| | | | | |

+-v----v----v----v-------------------v---------v--+

| | | | | | | | | | |

+-------------------------------------------------+

4. Gather:排序完後,再將所有桶中元素依序放回原始的陣列。

Original array

+-------------------------------------------------+

| 6 | 9 | 14 | 28 | 36 | 37 | 71 | 74 | 91 | 96 |

+-------------------------------------------------+

效能

| Complexity | |

|---|---|

| Worst | $O(n^2) $ |

| Best | $O(n + k) $ |

| Average | $O(n + k) $ |

| Worst space | $O(n + k) $ auxiliary |

$k $ = 桶子的數量(number of buckets) $n $ = 資料筆數

Worst case

Bucket sort 是一個分配式排序法,對資料分佈有既定的預期:「所有元素平均分佈在每個 bucket 的區間內」。可想而知,最差的狀況是所有元素都聚集(clustering)在同一個 bucket 中,整個 bucket sort 的會退化成單一一個 inner sort 的複雜度。而桶內排序通常選用 insertion sort(最差 $O(n^2) $),所以最差的時間複雜度為「 $O(n^2) $」。

Best case

最佳的狀況則是完全符合預期的平均分佈,一個蘿蔔一個坑,每個桶內排序的最佳時間複雜度為 $O(n / k) $,再乘上桶子總數 $k $,僅需 $O(k \cdot (n / k)) = O(n) $。計算結果看起來非常合理,但實際上最佳時間複雜度為 $O(n + k) $,為什麼呢?

無庸置疑,桶內排序最佳時間複雜度為 $O(n / k) $,但別忘了這是省略常數項過後式子,進行符號運算時,較精確的表達是 $c_0 O(n / k) + c_1 $,對於實作層面的常數 $c_0 $ 和 $c_1 $ 則予以保留。

當我們乘上 $k $,試著算出總運算量時,

$$k \cdot (c_0(n / k) + c_1) $$

會得到:

$$ c_0n + c_1k $$

可以得知,整個計算與 $k $ 有關,所以需要耗時 $O(n + k) $。

撇開數學,我們從 pseudo code 來看。最佳情況下,將所有元素蒐集回陣列的步驟(Gather)如下:

for (each bucket b in all k buckets)

for (each element x in b)

append x to the array

最外層的迴圈依桶子數 $k $ 而定,至少需要執行 $k $ 次,複雜度為 $O(k) $。內層的迴圈則是每個桶內的元素都會執行,而我們的資料時均勻分布,因此執行時間與元素總數 $n $ 相關,為 $O(n) $。兩者加起來就是我們所說的 $O(n + k) $ 的最佳複雜度。

那 $k $ 究竟會是多少,影響會比 $n $ 大嗎?

端看桶子總數而定,若桶子總數很大,比元素個數 $n $ 大得多,則桶子總數對執行時間的影響恐較劇烈,就算大多數為空桶子,仍須挨家挨戶查看是否需要執行桶內排序。

Space Complexity

Bucket sort 須額外建立 $k $ 個桶子,每個桶子需要配置長度為 $n $ 的 array,因此空間複雜度為 $O(n \cdot k) $。如果以 dynamic array 實作 bucket,並考慮平攤分析(Amortized analysis),則空間複雜度降至 $O(n + k) $,這也是大多數人接受的分析結果,畢竟不會有人無聊到預先配置 $n \cdot k $ 個 empty bucket。

實作

Bucket

Bucket sort 有許多種各異的實作法,差異最大之處就是桶子 bucket 這部分。

#![allow(unused)] fn main() { /// Bucket to store elements. struct Bucket<H, T> { hash: H, values: Vec<T>, } impl<H, T> Bucket<H, T> { /// Create a new bucket and insert its first value. /// /// * `hash` - Hash value generated by hasher param of `bucket_sort`. /// * `value` - Value to be put in the bucket. pub fn new(hash: H, value: T) -> Bucket<H, T> { Bucket { hash: hash, values: vec![value], } } } }

這裡的桶子實作兩個 struct fields:

values:使用Vec儲存對應範圍內的元素hash:Bucket Sort 主函式有一個hasher函式,會計算出對應各個桶子的雜湊值,因此要確保桶子的雜湊值有唯一性。

Sorting

接下來就是排序主函式。依照慣例,先看看函式的宣告(function signature)。

#![allow(unused)] fn main() { pub fn bucket_sort<H, F, T>(arr: &mut [T], hasher: F) where H: Ord, F: Fn(&T) -> H, T: Ord + Clone, }

這個 bucket_sort 函式使用了不少泛型:

H:hasher函式的回傳型別,用來辨識不同的桶子。F:hasher函式自身,只需要一個參數&T,回傳一個H。T:欲排序資料的型別。

函式自身稍微複雜一點,但仍不脫離四步驟:Create buckets、Scatter、Inner sort,還有 Gather。

#![allow(unused)] fn main() { pub fn bucket_sort() { // ... // 1. Create buckets. let mut buckets: Vec<Bucket<H, T>> = Vec::new(); // 2. Scatter for value in arr.iter() { let hash = hasher(&value); // 2.1. let value = value.clone(); // 2.2. match buckets.binary_search_by(|bucket| bucket.hash.cmp(&hash)) { // If exists, push the value to the bucket. Ok(index) => buckets[index].values.push(value), // If none, create and new bucket and insert value in. Err(index) => buckets.insert(index, Bucket::new(hash, value)), } } // 3. Inner sort and gather let ret = buckets.into_iter().flat_map(|mut bucket| { bucket.values.sort(); // 3.1. bucket.values }).collect::<Vec<T>>(); // 3.2. arr.clone_from_slice(&ret); // 4 Copy to original array } }

- 一般來說,第一步會配置完所有桶子,但這裡實作僅建立儲存桶子們的容器

buckets,這是由於實作了hasher函式,元素對應桶子的邏輯交由外部決定,因此桶子不需事先配置,而是交給第二步驟時 on-the-fly 建立。 - 疊代輸入的

arr,將元素散佈到桶子中。- 使用元素值

value取得雜湊值。 - 從一堆桶子內

buckets尋找對應雜湊值的桶子,如有對應桶子,則將待排序元素插入桶中;若無對應桶子,則馬上建立桶子,並插入待排序元素。

- 使用元素值

- 由於桶子們

buckets是一個二維陣列集合,我們使用flat_map將之壓平。- 使用 Rust 內建 sort(Timsort 的變形)作為我們 inner sort 的實作,將桶內所有元素排好序

- 別忘了 Rust 的 Iterator 很 lazy,記得要使用

collect蒐集 iterator 實作後的結果。

- 由於要模擬 in-place 原地排序法的特性,將排序好的資料再次拷貝到

arr上。這也是為什麼函式元素泛型T需要Clonetrait 的原因了。

有關於步驟 2.2.,這部分可以用 HashMap 的變形 IndexMap(一個保存插入順序的有序 HashMap)保存雜湊值對應桶子的資訊,使得外界更容易依雜湊值找到桶子。但為了保持範例程式的簡潔,決定不引入第三方的 crate(Rust 語言第三方模組的代稱),且 binary_search_by 的複雜度為 $O(\log n) $,對 Bucket sort 最差複雜度並無影響。

參考資料

- Wiki: Bucket sort

- Wiki: Amortized analysis

- How is the complexity of bucket sort is O(n+k) if we implement buckets using linked lists?

- Bucket sort in Rust

基數排序 Radix sort

如果你對 Counting sort 與 Bucket sort 有認識,應該知道這兩個排序都能突破比較排序法複雜度 $O(n \log n) $ 限制的特殊排序法。Radix sort 同樣是個特殊的整數排序法,效能同樣可達突破限制。差別在於,前兩者僅依據一個鍵值排序,而 Radix sort 則是依據多個鍵值排序。

舉例來說,欲排序一群範圍在 0 - 999 的整數,若以 Counting sort 排序,則需建立一個「1000 元素的陣列」來計算每個整數的出現次數;若使用以 10 為基數的 Radix sort,則僅需以個位數、十位數、百位數作為鍵值分別排序三次。通常 Radix sort 的排序副程式(Sorting subroutine)會選用 Counting sort 或 Bucket sort,而以 10 為基數的鍵值範圍僅 0 - 9,這種小範圍整數非常適合 Counting sort 作為排序副程式,節省了配置 int arr[1000] 的 count array 的時空間。

Radix sort 基本特性如下:

- 整數排序法:以整數作為排序的鍵值。

- 分配式排序法:不透過兩兩比較,而是分析鍵值分佈來排序。特定情況下可達線性執行時間。

- 穩定性:採用 LSD 的 Radix sort 屬穩定排序法(Stable sort);透過優化,採用 MSD 也可以是穩定排序法。

步驟

常見的 Radix sort 依據整數的每個位數來排序,依照位數排序的先後順序,可分為兩種:

- Least significant digit (LSD):從最低有效鍵值開始排序(最小位數排到大)。

- Most significant digit (MSD):從最高有效鍵值開始排序(最大位數排到小)。

簡單的 LSD Radix sort 步驟如下:

- LSD of each key:取得每個資料鍵值的最小位數(LSD)。

- Sorting subroutine:依據該位數大小排序資料。

- Repeating:取得下一個有效位數,並重複步驟二,至最大位數(MSD)為止。

而 MSD Radix sort 的步驟相似,但取得資料鍵值的方向相反。

- MSD of each key:取得每個資料鍵值的最大位數(MSD)。

- Sorting subroutine:依據該位數大小排序資料。

- Repeating:取得下一個有效位數,並重複步驟二,至最小位數(LSD)為止。

由於 MSD Radix sort 先排序最大位數,會出現 8 > 126 的結果,這種順序通常稱為 Lexicographical order,有如字典一般,越前面的字母排序權重越重,也因此,基本版的 MSD Radix sort 並非穩定排序法。

說明

我們選用 LSD Radix sort 示範,並且為了增加可讀性,將基數設為 10。需注意在現實場景中,有時使用 bytes 作為基數可能更適合。

待排序的數列如下。

[170, 45, 75, 90, 802, 2, 24, 66]

Radix sort 的排序副程式,通常選用 counting sort 或 bucket sort,因此,開始排序前,需建立供其使用的 buckets(或 count array)。這屬於其他排序法的範疇,有興趣可看 Counting sort 或 Bucket sort。

首先,從最小位數開始排序。 注意,同樣鍵值的資料,相對位置不會改變(穩定排序)。

0 5 5 0 2 2 4 6

_ _ _ _ _ _ _ _

[170, 45, 75, 90, 802, 2, 24, 66]

sort by rightmost digit -->

0 0 2 2 4 5 5 6

_ _ _ _ _ _ _ _

[170, 90, 802, 2, 24, 45, 75, 66]

再來,對下一個位數排序資料。位數不足的資料,予以補 0。

7 9 0 0 2 4 7 6

_ _ _ _ _ _ _

[170, 90, 802, 2, 24, 45, 75, 66]

sort by next digit -->

0 0 2 4 6 7 7 9

_ _ _ _ _ _ _

[802, 2, 24, 45, 66, 170, 75, 90]

最終,對最後一個位數進行排序。大功告成!

8 0 0 0 0 1 0 0

_ _

[802, 2, 24, 45, 66, 170, 75, 90]

sort by leftmost digit -->

0 0 0 0 0 0 1 8

_ _

[2, 24, 45, 66, 75, 90, 170, 802]

效能

| Complexity | |

|---|---|

| Worst | $O(dn) $ |

| Best | $O(dn) $ |

| Average | $O(dn) $ |

| Worst space | $O(d + n) $ auxiliary |

$n $:資料筆數。

$d $:number of digit,資料中最多有幾個位數(或鍵值)。

$k $:基數,就是一個位數最多有幾種可能的值。

Time complexity

欲分析 Radix sort 的時間複雜度,我們可以逐一擊破,先從排序副程式開始分析。

Radix sort 的 subroutine 通常採用 Counting sort 或 Bucket sort,因此每個 subroutine 的複雜度為 $O(n + k) $, $k $ 為 key 的範圍,以 10 為基數,就是 0 - 9 之間 $k = 10 $。

再來,我們分析整個主程式,Radix sort 每個位數各需排序一次,若最多位數的資料有 $d $ 位數,時間複雜度需乘上 $d $,為 $O(d (n + k)) $,那這個 $k $ 是否可以捨去呢?

分析 Counting sort 或 Bucket sort 時,範圍 $k $ 會隨輸入資料而變化,若 $k $ 過大,對複雜度的影響甚至會超過 $n $,因此分析複雜度時無法將 $k $ 捨去。而在 Radix sort, $k $ 通常為一個已知的常數,例如以 bytes 為基數 $k = 8 $, $k $ 可以捨去。最後可得 Radix sort 的時間複雜度為 $O(d \cdot n) $。

Space complexity

Radix sort 的空間複雜度同樣取決於排序副程式,Counting sort 與 Bucket sort 的空間複雜度皆為 $O(n \cdot k) $。Radix sort 的 $k $ 是常數,予以捨去。再乘上 $d $ 個位數,最差的空間複雜度為 $O(d \cdot n) $。

實作

這裡示範實作以 10 為基數,用來排序非負整數的 Radix sort。

首先,我們的排序副程式使用 Counting sort。

#![allow(unused)] fn main() { // 0. Include counting sort. use ::sorting::counting_sort; }

再來,就是 Radix sort 本體了。為了凸顯 Radix sort 的概念,簡化了函式參數數量,除去泛型宣告,並將基數選擇寫死在函式裡。

#![allow(unused)] fn main() { pub fn radix_sort(arr: &mut [i32]) { let radix = 10; // 1 let mut digit = 1; // 2 let max_value = arr // 3 .iter() .max() .unwrap_or(&0) .clone(); while digit <= max_value { // 4 counting_sort(arr, 0, 9, |t| (t / digit % radix) as usize); // 5 digit *= radix; // 6 } } }

- 設定基數為 10。

- 設定一個旗標,記錄當前在排序哪一位數,1 表示從最小位數(個位數)開始。

- 先找到輸入資料的最大值,作為之後副程式迴圈結束的條件。尋找最大值的複雜度為 $O(n)$,因此不影響 Radix Sort 的複雜度。如果

arr為空序列,則最大值設為 0,在第四步驟就會自動結束排序。 - 判斷當前排序的位數是否大於最大值,例如當前排序百分位,

digit為100,而最大值x為 26,則不需再排序百分位。 - 使用 Counting sort 作為排序副程式,只需要有 0 - 9 十個桶子。而

key參數則取出當前欲比較的位數。 - 位數乘上基數,移至下一個位數繼續比較。

小提醒:這是簡單又容易理解的實作,相對有許多額外的運算開銷(例如尋找最大值)。實務上,會在對資料有些了解才採用 Radix sort,因此實作並不會這麼 naive。

參考資料

堆疊 Stack

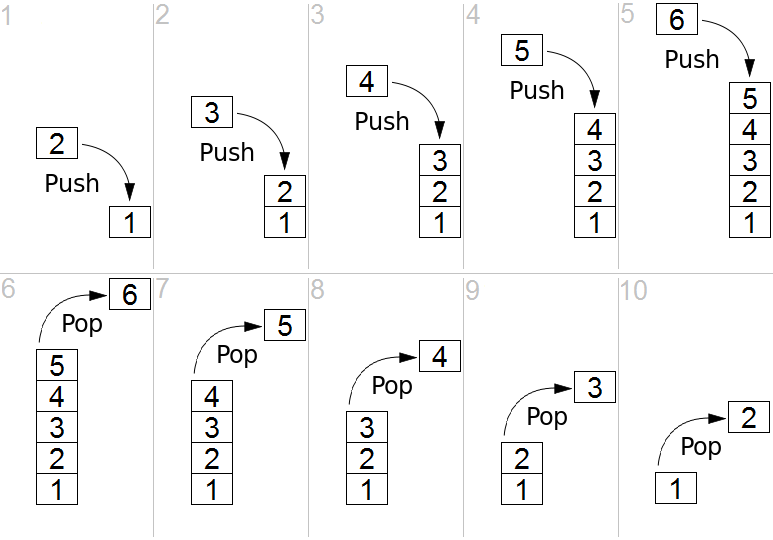

堆疊是一個具有後進先出 LIFO 特性的資料結構。以從 Wikipedia 借來的上圖為例,在第五張圖的狀況下,如果要取得 2,就必須先把 3、4、5 都退出堆疊。

堆疊的底部與頂部都是抽象的概念,頂部是資料被加入、移除、較為繁忙的那一端,底部即另一端。

堆疊的空間可能是有限的,亦即也有可能實現空間無限的堆疊。有鑑於有限空間的堆疊較為常見,我們選擇實作空間有限的堆疊。

堆疊 stack 有兩種實作方式:陣列 array 與鏈結串列 linked list,在此選擇以類似陣列的 Vector 實現。

本次實作的程式碼置於

rust_algorithm_club::collections::StackAPI 文件中。

架構設計

#![allow(unused)] fn main() { pub struct Stack<T> { maxsize: usize, items: Vec<T>, } }

maxsize 用於模擬堆疊空間有限的特性;items 負責保存加入堆疊的資料。

在此刻意將 maxsize、items 定義為 private member,避免外部直接存取。

基本操作

with_capacity:定義一個空間有限的堆疊。push:將新資料加入資料結構。pop:將最新加入的資料移出資料結構。size:(選用)取得堆疊的大小。peek:(選用)在不將資料退出堆疊的情況下偷看最後加入堆疊的資料。

定義一個空間有限的堆疊

#![allow(unused)] fn main() { pub fn with_capacity(maxsize: usize) -> Self { Self { maxsize, items: Vec::with_capacity(maxsize), } } }

初始化一個帶有預先分配空間 Vector 的堆疊。

⚠ 注意,即使預先分配了有限的空間,Rust 的 vector 在空間已滿的情況下會重新分配。假設一開始為 vector 分配了 10 單位的空間,在將第 11 筆資料插入 vector 前,vector 在記憶體的空間將被重新分配,以容納這第 11 筆資料。為了模擬堆疊空間有限的特性,我們會在 push 的操作動點手腳。

將新資料加入資料結構

#![allow(unused)] fn main() { pub fn push(&mut self, item: T) -> bool { if self.items.len() == self.maxsize { return false; } self.items.push(item); return true; } }

由於 push 操作會改變 items,因此需要堆疊的 mutable reference。由於 Rust 的 vector 有重新分配的特性,在將資料正式加入堆疊之前,必須先檢查堆疊初始化時設定的空間是否已經被塞滿了。如果結果為是,則拒絕將資料加入堆疊。

將最新加入的資料移出資料結構

#![allow(unused)] fn main() { pub fn pop(&mut self) -> Option<T> { self.items.pop() } }

堆疊有可能是空的,在此以 Option 表現這個情況。如果針對一個空堆疊進行 pop 操作,將會得到 None。

取得堆疊的大小

#![allow(unused)] fn main() { pub fn size(&self) -> usize { self.items.len() } }

一個空堆疊的大小是 0,加入一筆資料後是 1⋯⋯以此類推。注意容量 capcity 與大小 size 是兩個不同的概念。容量是這個堆疊最多可以塞下多少資料,大小則是這個堆疊已經被塞入了多少資料。由於 push 的檢查機制,堆疊的大小永遠不會超過 maxsize。

在不將資料退出堆疊的情況下偷看最後加入堆疊的資料

#![allow(unused)] fn main() { pub fn peek(&self) -> Option<&T> { self.items.last() } }

與 pop 操作類似,但不會對堆疊造成任何影響。如果偷看的是一個空堆疊,會得到 None。

效能

| Operation | Best Complexity | Worst Complexity |

|---|---|---|

| push (insert) | O(1) | O(1) |

| pop (delete) | O(1) | O(1) |

無論堆疊大小如何變化,push 與 pop 的效能都不會被影響。

參考資料

佇列 Queue

佇列是一個具有先進先出 FIFO 特性的資料結構。從 Wikipedia 上的圖為例,一個資料從左邊進入佇列並從右邊離開,最先進入佇列的資料會最先被取出。

佇列常見實作方式有:陣列 array、鏈結串列 linked list。為了使概念容易理解,我們選擇以類似陣列的 Vector 實作。

本次實作的程式碼置於

rust_algorithm_club::collections::QueueAPI 文件中。

架構設計

#![allow(unused)] fn main() { pub struct Queue<T> { items: Vec<T>, } }

以 items 保存加入佇列的資料。大部分用陣列實作的佇列可能會有 front 和 rear 兩個欄位負責保存指向佇列開頭和尾端的索引,作為佇列新增刪除資料的依據,但是透過 Rust 的 std::vec::Vec(線形動態成長的陣列容器),我們可以直接取得佇列第一以及最後一筆資料,所以這邊實作忽略這兩個欄位。

基本操作

enqueue:將新資料加入佇列dequeue:將最先放入的資料移出佇列peek:在不將資料移出佇列的情況下取得最先放入的資料size:取得佇列大小

定義佇列

#![allow(unused)] fn main() { pub fn new() -> Self { Self { items: Vec::new() } } }

初始化具有 Vec 的佇列。

將新資料加入佇列

#![allow(unused)] fn main() { pub fn enqueue(&mut self, item: T) { self.items.push(item); } }

由於 enqueue 會改變 items,因此需要佇列的 mutable reference。再來,我們沒有限制佇列大小,全由 Rust 的 Vec 自行分配空間,將新資料放到 items 的最後端。

將最先放入的資料移出佇列

#![allow(unused)] fn main() { pub fn dequeue(&mut self) -> Option<T> { match self.items.is_empty() { false => Some(self.items.remove(0)), true => None, } } }

items 有可能是空的,在移出資料之前需要檢查,然後移出 index 為零的資料,也就是最先放入的資料。

取得佇列大小

#![allow(unused)] fn main() { pub fn size(&self) -> usize { self.items.len() } }

取得 items 的大小。

不改變佇列的情況下,取得最先放入的資料

#![allow(unused)] fn main() { pub fn peek(&self) -> Option<&T> { self.items.first() } }

這裡的作法很單純,就是呼叫 Vec 底層 slice::first,回傳一個 Option<T>,不會影響到底層的

Vec 的內容。

效能

| Operation | Best Complexity | Worst Complexity |

|---|---|---|

| enqueue (insert) | O(1) | O(1) |

| dequeue (delete) | O(n)* | O(n)* |

*:注意,一般來說 dequeue 會選用 O(1) 的實作方式,這裡直接呼叫 Vec::remove 會導致整個 Vec<T> 的元素向前位移一個,是較耗費計算資源的 O(n) 操作。

我們可以選用其他方式實作,例如用額外指標紀錄當前 head 所在位置的雙端佇列 Deque,或是使用單向鏈結串列 Singly linked list 實作,都能達到 O(1) 的時間複雜度。

參考資料

雙端佇列 Deque

雙端佇列(double-ended queue,通常縮寫為 deque)是一般化(generalize)的佇列或堆疊。比起佇列只能「先進先出 FIFO」,以及堆疊只有「後進先出 LIFO」,雙端佇列可以從最前端或最末端任意方向,在常數時間複雜度內增刪元素,更為方便。

雙端佇列常見用動態陣列或是鏈結串列實作,動態陣列的實作會因空間不夠,需要重新配置記憶體,但通常會支援隨機存取(random access);鏈結串列的實作版本雖無法隨機存取,相對地增刪元素不需記憶體重配置。

雙端佇列顯著的缺點是:無論以動態陣列或連結串列實作,基本款實作通常無法在 $O(k)$ 時間複雜度的情況下,選定範圍內 k 個元素並取得單一切片(slice)。這肇因於動態陣列的實作通常內部儲存空間經過多次增刪,空間利用會不連續;而用鏈結串列實作者,則因不支援隨機存取而無法達到相應的複雜度。

本次實作的程式碼置於在

rust_algorithm_club::collections::DequeAPI 文件中。

架構設計

雙端佇列有個實作重點:可在常數時間從頭尾兩端增刪元素。在資料結構設計上,會儲存分別指向頭尾的兩個指標,長相可能如下:

#![allow(unused)] fn main() { struct Deque { head: usize, tail: usize, storage: SomeStorageType, } }

第一直覺肯定是選用雙向鏈結串列可以雙向增刪節點的特性,作為解決方案。不過這裡我們採用動態陣列實作,更精確來說,底層儲存容器同樣是有兩個分別指向頭尾的指標的「環形緩衝區(Ring buffer)」。

環形緩衝區

環形緩衝區(Ring buffer) 是一個長度大小固定的緩衝區,可以視為頭尾相連的記憶體區塊,上圖雖以環狀呈現,但在計算機架構中儲存方式通常是線性陣列,再搭配指向頭端的 head 與指向尾端的 tail 兩個指標構成。

環形緩衝區有分兩種,一種是有循環的,緩衝區寫滿了就覆蓋尾端舊的資料,另一種是不會循環,緩衝區會放滿的,後者就是本次實作會用到的,以下將來探討:

- 如何表示環形緩衝區為空

- 如何表示環形緩衝區已滿

- 環形緩衝區如何增加元素

這節以 ASCII chart 表示之。

h: headt: tailx: no data[number]: has data

下面一個容量為 8,尚未有任何元素存入的環形緩衝區,這裡觀察到,若 head 與 tail 指向的儲存單元相同,換句話說兩者索引值相同,則緩衝區為空。

scenario: empty buffer

h

t

---------------

x x x x x x x x

---------------

再來,從頭端增加一個元素,此時 head 指向的儲存單元會存入元素,並且 head 索引加一。

scenario: add one data onto head

t h

---------------

1 x x x x x x x

---------------

我們再連續加幾個元素,可以觀察到,head 最終指向的儲存單元永遠為空:

scenario: add more data onto head

t h

---------------

1 2 x x x x x x

---------------

t h

---------------

1 2 3 x x x x x

---------------

t h

---------------

1 2 3 4 x x x x

---------------

再來,我們從尾端增加元素,首先 tail 減一,並在移動過後的 tail 指向的儲存單元放入元素。因為 tail 原本為 0,減一之後為 -1,但索引不該有 -1,所以我們採取類似環繞算術運算(wrapping arithmetic operation)處理整數溢位,因此 tail 索引從 0 變成 7(總共 8 個儲存單元)。

scenario: add data onto tail

h t

---------------

1 2 3 4 x x x 5

---------------

日常生活中,環繞算術運算可見於汽車儀錶板或是電錶,9999 轉過頭後會自動變成 0000,可以想像成在萬分位進位了,但我們看不到。上述減一也可以想像二進位退一位,但我們看不到,所以從

0b000(0)變成了0b111(7)。

我們從尾端加更多資料到緩衝區:

scenario: add more data onto tail

h t

---------------

1 2 3 4 x x 6 5

---------------

h t

---------------

1 2 3 4 x 7 6 5 --> full

---------------

欸,怎麼加到第七個就停了?

由於目前僅探討不循環的環形緩衝區,已經規範 head = tail 代表緩衝區為空,如果貿然加上第八個元素,就無法分辨緩衝區是空是滿,恐導致轉盈為空。所以當緩衝區容量減去元素個數為 1 時,換句話說就是當剩餘最後一個空儲存單元時,表示該緩衝區已滿,不能再增加元素。由此推論環形緩衝區永遠會剩下一個沒使用的儲存單元。

至此,環形緩衝區的特性很符合雙端佇列的需求,總結一下:

head = tail時,表示緩衝區為空。- 容量僅剩一個儲存單元時,表示緩衝區已滿。

- head 永遠指向一個空的儲存單元。

- 邏輯索引的映射會利用環繞算術運算配合模除運算,將索引值限制在緩衝區範圍內。

第四點很難懂齁?免驚,下面實作範例「邏輯索引映射」段落就會解釋給你聽!

手動配置記憶體

這一段,我們將為環形緩衝區打造屬於它自己的底層儲存空間。你可能想問,既然環形緩衝區是一個固定長度的陣列,為什麼不直接利用 Rust 標準函式庫的 Vec 呢?因為 Vec 的容量和記憶體配置屬於實作細節,雖然目前是滿了才擴充容量重新配置空間,但難保未來改變,為了更細緻控制記憶體,決定弄髒手,自行配置記憶體。

⚠️ 以下範例有

unsafe程式碼,未經審計,請謹慎使用。

首先,宣告一個 RawVec 結構體,儲存了兩個欄位:

#![allow(unused)] fn main() { struct RawVec<T> { ptr: *mut T, cap: usize, } }

接下來,我們要為 RawVec 實作三個方法,完成自我管理記憶體的偉大志向:

with_capacity:建立指定容量的RawVec,會在堆疊上配置一塊記憶體。try_grow:嘗試將RawVec的容量加倍,會觸發記憶體的重新配置。drop:實作Drop特徵,會釋放在堆疊上手動配置的記憶體。

先來看 with_capacity:

#![allow(unused)] fn main() { impl<T> RawVec<T> { // ... pub fn with_capacity(cap: usize) -> Self { let layout = Layout::array::<T>(cap).unwrap(); // 1 // 2 if layout.size() == 0 { // This is safe for zero sized types. However, be careful when facing // zero capacity layouts. It must be replaced with an actual pointer // before operations such as dereference or read/write. let ptr = ptr::NonNull::dangling().as_ptr(); // 3 Self { ptr, cap: 0 } } else { // This is safe because it conforms to the [safety contracts][1]. // // [1]: https://doc.rust-lang.org/1.49.0/alloc/alloc/trait.GlobalAlloc.html#safety-1 let ptr = unsafe { alloc(layout) }; // 4 if ptr.is_null() { handle_alloc_error(layout); } Self { ptr: ptr.cast(), cap, } } } } }

- 首先,我們先透過

Layout::array取得給定長度給定型別的陣列的記憶體佈局,這個佈局包含記憶體對齊(二的倍數的位元組)與佔用記憶體大小等資訊。 - 再來這個

layout.size()條件式是因為alloc為unsafe函式,需遵守其安全條款:不允許配置大小為零的空間。因此,必須判斷實際上需要配置記憶體與否,有兩種情況不需配置:T是 Zero Sized Types(ZSTs),也就是不需要空間的型別。cap為零,所以不需要容量。

- 若記憶體佈局所佔空間大小為零,則配置一個

NonNull的迷途指標。- 對 ZST 來說,

NonNull是安全的,ZST 的指標算術操作無論如何加減,都會指向原始的指標位址,所以上層可以零成本的抽象操作容器的各種方法,完全不需要配置額外記憶體區塊。 - 對非 ZST 但容量為零的記憶體佈局來說,

NonNull不會有危害但要非常小心,只有在容量大於 0 且內容有初始化時,才該允許指標算術,否則可能存取到未初始化的記憶體位址,進而引發未定義行為。

- 對 ZST 來說,

- 很簡單地呼叫

alloc讓 Rust 全域預設的配置器幹一塊空間資源來。因為alloc發生記憶體配置錯誤時會回傳空指標,所以這裡按照官方建議用handle_alloc_error捕捉這個行為,防止空指標被當作合法指標使用。

Rust 1.28 導入 Global allocators 的功能,讓使用者使用

#[global_allocator]屬性,替標準函式庫註冊全域的記憶體配置器,也因此,上述的alloc、realloc、dealloc即將在 allocator_api 穩定後被取代。

看完配置記憶體,來看如何手動釋放記憶體。Rust 的 Drop 特徵有 drop() 方法,會在數值不需要時呼叫,類似其他語言的解構函式(destructor)。我們將釋放記憶體的邏輯放在 RawVec::drop 裡面,當 RawVec 不被需要時,就會協助我們釋放手動配置的記憶體。

#![allow(unused)] fn main() { impl<T> Drop for RawVec<T> { /// Deallocates the underlying memory region by calculating the type layout /// and number of elements. /// /// This only drop the memory block allocated by `RawVec` itself but not /// dropping the contents. Callers need to drop the contents by themselves. fn drop(&mut self) { let layout = Layout::array::<T>(self.cap).unwrap(); // 1 if layout.size() > 0 { // This is safe because it conforms to the [safety contracts][1]. // // [1]: https://doc.rust-lang.org/1.49.0/alloc/alloc/trait.GlobalAlloc.html#safety-2 unsafe { dealloc(self.ptr.cast(), layout) } } } } }

實作上,第一步取得當前記憶體佈局,並透過 dealloc 配合指標來釋放記憶體。當然,ZST 或是容量為零的狀況並沒有配置記憶體,額外判斷無需釋放。

最後,來瞧瞧 try_grow,為了簡化實作,每次呼叫時,記憶體區塊就單純加倍。